Update https://docs.ultralytics.com/models (#6513)

Signed-off-by: Glenn Jocher <glenn.jocher@ultralytics.com> Co-authored-by: pre-commit-ci[bot] <66853113+pre-commit-ci[bot]@users.noreply.github.com>

This commit is contained in:

parent

0c4e97443b

commit

16a13a1ce0

178 changed files with 14224 additions and 561 deletions

193

docs/hi/models/fast-sam.md

Normal file

193

docs/hi/models/fast-sam.md

Normal file

|

|

@ -0,0 +1,193 @@

|

|||

---

|

||||

comments: true

|

||||

description: FastSAM एक सीएनएन पर आधारित समाधान है जो छवियों में वास्तविक समय ऑब्जेक्ट सेगमेंटेशन के लिए बनाया गया है। यह यूजर इंटरेक्शन, संगणनीय प्रभावशीलता और विजन कार्यों को अनुकूलित करने में सक्षम है।

|

||||

keywords: FastSAM, machine learning, CNN-based solution, object segmentation, वास्तविक समय का समाधान, Ultralytics, विजन कार्य, छवि प्रोसेसिंग, उद्योगिक अनुप्रयोग, यूजर इंटरैक्शन

|

||||

---

|

||||

|

||||

# Fast Segment Anything Model (FastSAM)

|

||||

|

||||

फास्ट सेगमेंट एनीथिंग मॉडल (फास्टएसएएम) एक नवीन, वास्तविक समय में कार्यरत सीएनएन पर आधारित समाधान है जो एनीथिंग टास्क को सेगमेंट करने के लिए बनाया गया है। इस टास्क का उद्देश्य विभिन्न संभावित उपयोक्ता इंटरेक्शन प्रोम्प्ट्स पर आधारित छवियों में किसी भी ऑब्जेक्ट को सेगमेंट करना है। फास्टएसएएम ने संगणनात्मक मांग को कम करते हुए मुकाबले क्षमता को बरकरार रखते हुए संगणकीय मांगों को काफी कम किया है, जिसके कारण यह विभिन्न विजन कार्यों के लिए एक व्यावहारिक विकल्प बनाता है।

|

||||

|

||||

|

||||

|

||||

## अवलोकन

|

||||

|

||||

FastSAM, [सेगमेंट एनीथिंग मॉडल (एसएएम)](sam.md) की सीमाओं का सामना करने के लिए बनाया गया है, जो एक भारी ट्रांसफॉर्मर मॉडल है और उचित संसाधन आवश्यकताओं को है। फास्टएसएएम ने सार्वभौमिक चरणों में सेगमेंट एनीथिंग टास्क को अलग-अलग दो साँप्रदायिक चरणों में अलग किया है: सभी इंस्टेंस सेगमेंटेशन और प्रॉम्प्ट-गाइडेड चयन। पहले चरण में, यह [व्योलोवी8-सेग](../tasks/segment.md) का उपयोग करके छवि में सभी इंस्टेंस की सेगमेंटेशन मास्क उत्पन्न करता है। दूसरे चरण में, यह प्रोम्प्ट के बराबर क्षेत्र-ऑफ-इंटरेस्ट को आउटपुट करता है।

|

||||

|

||||

## प्रमुख सुविधाएं

|

||||

|

||||

1. **वास्तविक समय का समाधान:** सीएनएन की संगणनात्मक प्रभावशीलता का उपयोग करके, फास्टएसएएम एनीथिंग टास्क के लिए वास्तविक समय समाधान प्रदान करता है, जिससे यह उद्योगिक अनुप्रयोगों के लिए महत्वपूर्ण परिणामों की आवश्यकता होती है।

|

||||

|

||||

2. **प्रदार्थी और प्रदर्शन क्षमता:** फास्टएसएएम संगणनात्मक और संसाधन मांग में काफी कमी प्रदान करता है बिना प्रदर्शन गुणवत्ता पर कुछ बदले के। यह संसाधनों की बहुत अधिक कमी के साथ एसएएम के लगभग तुलनात्मक प्रदर्शन प्राप्त करता है, जिससे वास्तविक समय अनुप्रयोग संभव होता है।

|

||||

|

||||

3. **प्रोम्प्ट-गाइडेड सेगमेंटेशन:** फास्टएसएएम कई संभावित उपयोक्ता इंटरेक्शन प्रोम्प्ट्स द्वारा निर्दिष्ट छवि में किसी भी ऑब्जेक्ट को सेगमेंट कर सकता है, जो विभिन्न परिस्थितियों में लचीलापूर्णता और अनुकूलन प्रदान करता है।

|

||||

|

||||

4. **व्योलोवी8-सेग पर आधारित:** फास्टएसएएम [व्योलोवी8-सेग](../tasks/segment.md) पर आधारित है, जो एक ऑब्जेक्ट डिटेक्टर है जिसमें एक इंस्टेंस सेगमेंटेशन टास्क है। इससे यह संभव होता है कि यह छवि में सभी इंस्टेंस की सेगमेंटेशन मास्क प्रभावी ढंग से उत्पन्न करें।

|

||||

|

||||

5. **बेंचमार्क पर प्रतिस्पर्धी परिणाम:** MS COCO पर ऑब्जेक्ट प्रासलन टास्क पर, फास्टएसएएम एकल NVIDIA RTX 3090 पर [एसएएम](sam.md) की तुलना में काफी तेज गति में उच्च अंक प्राप्त करता है, जो इसकी प्रभावशीलता और क्षमता को दिखाता है।

|

||||

|

||||

6. **वास्तविक अनुप्रयोग:** प्रस्तावित दृष्टांत एक नए, वास्तविक समय में कई विजन कार्यों के लिए एक नया, व्यावहारिक समाधान प्रदान करता है, जिसमें मौजूदा विधियों से कई या सौ गुना तेज तरीके से किया जाता है।

|

||||

|

||||

7. **मॉडल संक्षिप्ति क्षमता:** फास्टएसएएम ने प्रवेशी अभिकरण के लिए एक कृत्रिम प्राथमिकता को संरचना में परिचय कराने के द्वारा कंप्यूटेशनल प्रयास को काफी कम करने की संभावना दिखाई है, इस प्रकार सामान्य विजन कार्यों के लिए बड़े मॉडल आर्किटेक्चर के लिए नए संभावनाओं को खोलती है।

|

||||

|

||||

## उपलब्ध मॉडल, समर्थित कार्य और ऑपरेटिंग मोड

|

||||

|

||||

इस सारणी में उपलब्ध मॉडल, उनके विशिष्ट पूर्व-प्रशिक्षित वेट और उनके समर्थनित कार्यों को पेश किया गया है, साथ ही उनकी विभिन्न ऑपरेटिंग मोड के साथ संगतता को दर्शाने के लिए समर्थित मोजी में ✅ इमोज़ी और असमर्थित मोजी में ❌ इमोज़ी लगाए गए हैं।

|

||||

|

||||

| मॉडल प्रकार | पूर्व-प्रशिक्षित वेट्स | समर्थित कार्य | भावना | मान्यीकरण | प्रशिक्षण | निर्यात |

|

||||

|-----------------|------------------------|--------------------------------------------|-------|-----------|-----------|---------|

|

||||

| फास्टएसएएम-एस | `FastSAM-s.pt` | [इंस्टेंस सेगमेंटेशन](../tasks/segment.md) | ✅ | ❌ | ❌ | ✅ |

|

||||

| फास्टएसएएम-एक्स | `FastSAM-x.pt` | [इंस्टेंस सेगमेंटेशन](../tasks/segment.md) | ✅ | ❌ | ❌ | ✅ |

|

||||

|

||||

## उपयोग के उदाहरण

|

||||

|

||||

फास्टएसएएम मॉडल को अपने पायथन ऐप्लिकेशन में आसानी से एकीकृत करना आसान है। उल्ट्राल्याटिक्स उपयोगकर्ता-मित्रपूर्ण पायथन API और CLI कमांड्स प्रदान करता है ताकि विकास को सरल बनाया जा सके।

|

||||

|

||||

### पूर्वानुमान उपयोग

|

||||

|

||||

एक छवि पर ऑब्जेक्ट डिटेक्शन करने के लिए, नीचे दिए गए उदाहरण का उपयोग करें:

|

||||

|

||||

!!! Example "उदाहरण"

|

||||

|

||||

=== "पायथन"

|

||||

```python

|

||||

from ultralytics import FastSAM

|

||||

from ultralytics.models.fastsam import FastSAMPrompt

|

||||

|

||||

# एक inference source निर्धारित करें

|

||||

source = 'path/to/bus.jpg'

|

||||

|

||||

# एक फास्टएसएएम मॉडल बनाएं

|

||||

model = FastSAM('FastSAM-s.pt') # या FastSAM-x.pt

|

||||

|

||||

# छवि पर inference चलाएं

|

||||

everything_results = model(source, device='cpu', retina_masks=True, imgsz=1024, conf=0.4, iou=0.9)

|

||||

|

||||

# प्रोम्प्ट प्रक्रिया वस्तु को तैयार करें

|

||||

prompt_process = FastSAMPrompt(source, everything_results, device='cpu')

|

||||

|

||||

# सब कुछ प्रोम्प्ट

|

||||

ann = prompt_process.everything_prompt()

|

||||

|

||||

# बॉक्स डिफ़ॉल्टवत आकार [0,0,0,0] -> [x1,y1,x2,y2]

|

||||

ann = prompt_process.box_prompt(bbox=[200, 200, 300, 300])

|

||||

|

||||

# पाठ प्रोम्प्ट

|

||||

ann = prompt_process.text_prompt(text='a photo of a dog')

|

||||

|

||||

# पॉइंट प्रोम्प्ट

|

||||

# डिफ़ॉल्ट point [[0,0]] [[x1,y1],[x2,y2]]

|

||||

# डिफ़ॉल्ट point_label [0] [1,0] 0:background, 1:foreground

|

||||

ann = prompt_process.point_prompt(points=[[200, 200]], pointlabel=[1])

|

||||

prompt_process.plot(annotations=ann, output='./')

|

||||

```

|

||||

|

||||

=== "CLI"

|

||||

```bash

|

||||

# शीघ्रदर्शन मॉडल को लोड करें और उसे कुछ वस्तुओं के साथ सेगमेंट करें

|

||||

yolo segment predict model=FastSAM-s.pt source=path/to/bus.jpg imgsz=640

|

||||

```

|

||||

|

||||

यह स्निपेट प्रशिक्षित मॉडल को लोड करने और एक इमेज पर प्रभासिती का निर्धारण करने की सरलता का दिखावा करता है।

|

||||

|

||||

### वैल उपयोग

|

||||

|

||||

एक डेटासेट पर मॉडल की मान्यीकरण करने के लिए निम्नलिखित तरीके का उपयोग किया जा सकता है:

|

||||

|

||||

!!! Example "उदाहरण"

|

||||

|

||||

=== "पायथन"

|

||||

```python

|

||||

from ultralytics import FastSAM

|

||||

|

||||

# एक फास्टएसएएम मॉडल बनाएं

|

||||

model = FastSAM('FastSAM-s.pt') # या FastSAM-x.pt

|

||||

|

||||

# मॉडल को मान्यित करें

|

||||

results = model.val(data='coco8-seg.yaml')

|

||||

```

|

||||

|

||||

=== "CLI"

|

||||

```bash

|

||||

# शीघ्रदर्शन मॉडल को लोड करें और इसे साइज़ 640 पर COCO8 उदाहरण डेटासेट पर मान्यित करें

|

||||

yolo segment val model=FastSAM-s.pt data=coco8.yaml imgsz=640

|

||||

```

|

||||

|

||||

कृपया ध्यान दें कि फास्टएसएएम केवल एकल वस्तु कार और सेगमेंटेशन का समर्थन करता है। इसका मतलब है कि यह सभी ऑब्जेक्टों को एक ही वर्ग के रूप में मान्यता देगा और सभी ऑब्जेक्ट्स को एक ही वर्ग के रूप में सेगमेंट करेगा। इसलिए, डेटासेट को तैयार करते समय, आपको सभी ऑब्जेक्ट श्रेणी आईडी को 0 में रूपांतरित करने की आवश्यकता होगी।

|

||||

|

||||

## फास्टएसएएम आधिकारिक उपयोग

|

||||

|

||||

फास्टएसएएम को [https://github.com/CASIA-IVA-Lab/FastSAM](https://github.com/CASIA-IVA-Lab/FastSAM) रिपॉजिटरी से सीधे भी उपयोग किया जा सकता है। यहां आपको फास्टएसएएम का उपयोग करने के लिए आमतौर पर लिए जाने वाले कदमों का संक्षेपिक अवलोकन है:

|

||||

|

||||

### स्थापना

|

||||

|

||||

1. फास्टएसएएम रिपॉजिटरी क्लोन करें:

|

||||

```शेल

|

||||

git clone https://github.com/CASIA-IVA-Lab/FastSAM.git

|

||||

```

|

||||

|

||||

2. पायथन 3.9 के साथ एक रुपे में संचालित करने के लिए एक Conda वातावरण बनाएं और सक्रिय करें:

|

||||

```शेल

|

||||

conda create -n FastSAM python=3.9

|

||||

conda activate FastSAM

|

||||

```

|

||||

|

||||

3. क्लोन किए गए रिपॉजिटरी में जाएं और आवश्यक पैकेजों को स्थापित करें:

|

||||

```शेल

|

||||

cd FastSAM

|

||||

pip install -r requirements.txt

|

||||

```

|

||||

|

||||

4. CLIP मॉडल स्थापित करें:

|

||||

```शेल

|

||||

pip install git+https://github.com/openai/CLIP.git

|

||||

```

|

||||

|

||||

### उदाहरण उपयोग

|

||||

|

||||

1. [मॉडल चेकपॉइंट](https://drive.google.com/file/d/1m1sjY4ihXBU1fZXdQ-Xdj-mDltW-2Rqv/view?usp=sharing)डाउनलोड करें।

|

||||

|

||||

2. FastSAM का उपयोग करके इंफरेंस करें। उदाहरण कमांड:

|

||||

|

||||

- छवि में सब कुछ सेगमेंट करें:

|

||||

```शेल

|

||||

python Inference.py --model_path ./weights/FastSAM.pt --img_path ./images/dogs.jpg

|

||||

```

|

||||

|

||||

- पाठ प्रोम्प्ट का उपयोग करके विशेष ऑब्जेक्ट सेगमेंट करें:

|

||||

```शेल

|

||||

python Inference.py --model_path ./weights/FastSAM.pt --img_path ./images/dogs.jpg --text_prompt "the yellow dog"

|

||||

```

|

||||

|

||||

- एक बाउंडिंग बॉक्स के भीतर बाउंडर ऑब्जेक्ट को सेगमेंट करें (xywh स्वरूप में बॉक्स की कोणयों की निर्धारण करें):

|

||||

```शेल

|

||||

python Inference.py --model_path ./weights/FastSAM.pt --img_path ./images/dogs.jpg --box_prompt "[570,200,230,400]"

|

||||

```

|

||||

|

||||

- विशेष बिंदुओं के पास ऑब्जेक्ट को सेगमेंट करें:

|

||||

```शेल

|

||||

python Inference.py --model_path ./weights/FastSAM.pt --img_path ./images/dogs.jpg --point_prompt "[[520,360],[620,300]]" --point_label "[1,0]"

|

||||

```

|

||||

|

||||

इसके अलावा, आप फास्टएसएएम का उपयोग करने के लिए एक [कोलैब डेमो](https://colab.research.google.com/drive/1oX14f6IneGGw612WgVlAiy91UHwFAvr9?usp=sharing) या एक [हगिंगफेस वेब डेमो](https://huggingface.co/spaces/An-619/FastSAM) पर भी प्रयास कर सकते हैं।

|

||||

|

||||

## उद्धृति और प्रशंसापत्र

|

||||

|

||||

हम वास्तविक समय आवंटन संबंधी क्षेत्र में महत्वपूर्ण योगदान देने के लिए फास्टएसएएम लेखकों को प्रशंसा करते हैं:

|

||||

|

||||

!!! Quote ""

|

||||

|

||||

=== "बिबटेक्स्ट"

|

||||

|

||||

```बिबटेक्स्ट

|

||||

@misc{zhao2023fast,

|

||||

title={Fast Segment Anything},

|

||||

author={Xu Zhao and Wenchao Ding and Yongqi An and Yinglong Du and Tao Yu and Min Li and Ming Tang and Jinqiao Wang},

|

||||

year={2023},

|

||||

eprint={2306.12156},

|

||||

archivePrefix={arXiv},

|

||||

primaryClass={cs.CV}

|

||||

}

|

||||

```

|

||||

|

||||

[FastSAM](https://arxiv.org/abs/2306.12156) पेपर आरएक्सिव में मौजूद है। लेखकों ने अपना काम सार्वजनिक रूप से उपलब्ध कराया है, और कोडबेस [गिटहब](https://github.com/CASIA-IVA-Lab/FastSAM) पर उपलब्ध है। हम इन दोनों के प्रयासों की कीमत करते हैं और उनके प्रयास के लिए धन्यवाद देते हैं जो क्षेत्र को आगे बढ़ाने और अपने काम को व्यापक समुदाय के लिए उपलब्ध कराने में समर्थ हैं।

|

||||

|

|

@ -1,32 +1,32 @@

|

|||

---

|

||||

comments: true

|

||||

description: Ultralytics द्वारा समर्थित YOLO समूह, SAM, MobileSAM, FastSAM, YOLO-NAS, और RT-DETR मॉडल्स की विविधता का पता लगाएं। CLI और Python उपयोग के लिए उदाहरणों के साथ शुरू हो जाएं।

|

||||

keywords: Ultralytics, दस्तावेज़ीकरण, YOLO, SAM, MobileSAM, FastSAM, YOLO-NAS, RT-DETR, मॉडल, वास्तुरचना, Python, CLI

|

||||

description: Ultralytics द्वारा समर्थित YOLO परिवार की विविध रेंज, SAM, MobileSAM, FastSAM, YOLO-NAS, और RT-DETR मॉडल्स का पता लगाएं। CLI और Python उपयोग के लिए उदाहरणों के साथ प्रारंभ करें।

|

||||

keywords: Ultralytics, दस्तावेज़ीकरण, YOLO, SAM, MobileSAM, FastSAM, YOLO-NAS, RT-DETR, मॉडल्स, आर्किटेक्चर्स, Python, CLI

|

||||

---

|

||||

|

||||

# Ultralytics द्वारा समर्थित मॉडल्स

|

||||

# Ultralytics द्वारा समर्थित मॉडल

|

||||

|

||||

Ultralytics के मॉडल दस्तावेज़ीकरण में आपका स्वागत है! हम विशेष टास्क जैसे [ऑब्जेक्ट डिटेक्शन](../tasks/detect.md), [इंस्टेंस सेग्मेंटेशन](../tasks/segment.md), [छवि श्रेणीबद्धीकरण](../tasks/classify.md), [पोज़ संख्यानन](../tasks/pose.md), और [मल्टी-ऑब्जेक्ट ट्रैकिंग](../modes/track.md) के लिए विशेष रूप से तैयार किए गए मॉडल का समर्थन करते हैं। अगर आप अपनी मॉडल वास्तुरचना को Ultralytics में योगदान देना चाहते हैं, तो हमारे [योगदान गाइड](../../help/contributing.md) की जांच करें।

|

||||

Ultralytics के मॉडल दस्तावेज़ीकरण में आपका स्वागत है! हम [ऑब्जेक्ट डिटेक्शन](../tasks/detect.md), [इंस्टेंस सेगमेंटेशन](../tasks/segment.md), [इमेज क्लासिफिकेशन](../tasks/classify.md), [पोज़ एस्टिमेशन](../tasks/pose.md), और [मल्टी-ऑब्जेक्ट ट्रैकिंग](../modes/track.md) जैसे विशिष्ट कामों के लिए डिज़ाइन किए गए मॉडलों की एक विस्तृत रेंज का समर्थन प्रदान करते हैं। यदि आप Ultralytics में अपने मॉडल आर्किटेक्चर को योगदान देने में रुचि रखते हैं, तो हमारा [Contributing Guide](../../help/contributing.md) देखें।

|

||||

|

||||

!!! Note "नोट"

|

||||

!!! Note "ध्यान दें"

|

||||

|

||||

🚧 हमारी बहुभाषी दस्तावेज़ीकरण वर्तमान में निर्माणाधीन है, और हम उसे सुधारने के लिए कठिनताओं पर काम कर रहे हैं। धन्यवाद आपकी सहानुभूति के लिए! 🙏

|

||||

🚧 हमारी अलग-अलग भाषाओं में दस्तावेज़ीकरण वर्तमान में निर्माणाधीन है, और हम इसे सुधारने के लिए कठिन परिश्रम कर रहे हैं। धैर्य रखने के लिए धन्यवाद! 🙏

|

||||

|

||||

## प्रमुख मॉडल

|

||||

|

||||

यहां कुछ महत्वपूर्ण मॉडल हैं जिन्हें समर्थित किया जाता है:

|

||||

यहां कुछ मुख्य मॉडल दिए गए हैं:

|

||||

|

||||

1. **[YOLOv3](../../models/yolov3.md)**: YOLO मॉडल परिवार का तीसरा संस्करण, जो मूल रूप में Joseph Redmon द्वारा विकसित किया गया था, जिसे उसकी क्षमता के लिए जाना जाता है सही समय में ऑब्जेक्ट डिटेक्शन की।

|

||||

2. **[YOLOv4](../../models/yolov4.md)**: YOLOv3 के लिए एक डार्कनेट जन्मित अपडेट, जिसे Alexey Bochkovskiy ने 2020 में जारी किया।

|

||||

3. **[YOLOv5](../../models/yolov5.md)**: यूल्ट्रालिटिक्स द्वारा योगदान की एक सुधारी हुई YOLO वास्तुरचि। पिछले संस्करणों की तुलना में बेहतर प्रदर्शन और गति विपरीत संलग्नाता प्रदान करने का वादा।

|

||||

4. **[YOLOv6](../../models/yolov6.md)**: 2022 में [मेटुआन](https://about.meituan.com/) द्वारा जारी किया गया, और कंपनी के कई स्वतंत्र वितरण रोबोट में प्रयोग होता है।

|

||||

5. **[YOLOv7](../../models/yolov7.md)**: YOLOv4 के लेखकों द्वारा जारी किए गए नवीनतम YOLO मॉडल्स।

|

||||

6. **[YOLOv8](../../models/yolov8.md)**: YOLO परिवार का नवीनतम संस्करण, जिसमें घटनाक्रम सेग्मेंटेशन, पोज़/कीपॉइंट्स अनुमान, और वर्गीकरण जैसी बढ़ी हुई क्षमताएं होती हैं।

|

||||

7. **[सेगमेंट एनीथिंग मॉडल (SAM)](../../models/sam.md)**: मेटा का सेगमेंट एनीथिंग मॉडल (SAM)।

|

||||

8. **[मोबाइल सेगमेंट एनीथिंग मॉडल (MobileSAM)](../../models/mobile-sam.md)**: मोबाइल एप्लिकेशनों के लिए MobileSAM, Kyung Hee विश्वविद्यालय द्वारा।

|

||||

9. **[फ़ास्ट सेगमेंट एनीथिंग मॉडल (FastSAM)](../../models/fast-sam.md)**: दृश्य और वीडियो विश्लेषण समूह, स्वचालन विज्ञान संस्थान, चीन संगठन द्वारा FastSAM।

|

||||

10. **[YOLO-NAS](../../models/yolo-nas.md)**: YOLO Neural Architecture Search (NAS) मॉडल्स।

|

||||

11. **[रियलटाइम डिटेक्शन ट्रांसफॉर्मर (RT-DETR)](../../models/rtdetr.md)**: बाइडू का PaddlePaddle रियलटाइम डिटेक्शन ट्रांसफॉर्मर (RT-DETR) मॉडल।

|

||||

1. **[YOLOv3](yolov3.md)**: YOLO मॉडल परिवार का तीसरा संस्करण, जिसे जोसेफ रेडमोन द्वारा बनाया गया है, जो इसकी कुशल रियल-टाइम ऑब्जेक्ट डिटेक्शन क्षमताओं के लिए जाना जाता है।

|

||||

2. **[YOLOv4](yolov4.md)**: YOLOv3 को अपडेट करने वाला एक डार्कनेट-नेटिव, जिसे 2020 में एलेक्सी बोचकोवस्की द्वारा जारी किया गया।

|

||||

3. **[YOLOv5](yolov5.md)**: उल्ट्रालाइटिक्स द्वारा बेहतर YOLO आर्किटेक्चर का एक सुधारित संस्करण, जो पिछले संस्करणों की तुलना में बेहतर प्रदर्शन और गति की समझौता की पेशकश करता है।

|

||||

4. **[YOLOv6](yolov6.md)**: 2022 में [Meituan](https://about.meituan.com/) द्वारा जारी किया गया, और कंपनी के कई स्वायत्त डिलीवरी रोबोट्स में उपयोग में।

|

||||

5. **[YOLOv7](yolov7.md)**: 2022 में YOLOv4 के लेखकों द्वारा जारी किया गया अपडेटेड YOLO मॉडल।

|

||||

6. **[YOLOv8](yolov8.md) नया 🚀**: YOLO परिवार का नवीनतम संस्करण, जिसमें इंस्टेंस सेगमेंटेशन, पोज/कीपॉइंट्स अनुमान, और क्लासिफिकेशन जैसी उन्नत क्षमताएं शामिल हैं।

|

||||

7. **[Segment Anything Model (SAM)](sam.md)**: मेटा के Segment Anything Model (SAM)।

|

||||

8. **[Mobile Segment Anything Model (MobileSAM)](mobile-sam.md)**: मोबाइल एप्लिकेशनों के लिए MobileSAM, क्युंग ही यूनिवर्सिटी द्वारा।

|

||||

9. **[Fast Segment Anything Model (FastSAM)](fast-sam.md)**: चीनी विज्ञान अकादमी, ऑटोमेशन संस्थान के इमेज & वीडियो एनालिसिस ग्रुप द्वारा FastSAM।

|

||||

10. **[YOLO-NAS](yolo-nas.md)**: YOLO न्यूरल आर्किटेक्चर सर्च (NAS) मॉडल्स।

|

||||

11. **[Realtime Detection Transformers (RT-DETR)](rtdetr.md)**: बैदु के पडलपैडल Realtime Detection Transformer (RT-DETR) मॉडल।

|

||||

|

||||

<p align="center">

|

||||

<br>

|

||||

|

|

@ -36,59 +36,63 @@ Ultralytics के मॉडल दस्तावेज़ीकरण मे

|

|||

allowfullscreen>

|

||||

</iframe>

|

||||

<br>

|

||||

<strong>देखें:</strong> थोड़ी सी कोड के कुछ पंक्तियों में Ultralytics YOLO मॉडल चलाएँ।

|

||||

<strong>देखें:</strong> कुछ लाइनों के कोड में Ultralytics YOLO मॉडल्स को चलाएं।

|

||||

</p>

|

||||

|

||||

## प्रारंभ करना: उपयोग उदाहरण

|

||||

|

||||

यह उदाहरण योलो प्रशिक्षण और अनुमान के सरल उदाहरण प्रदान करता है। इन और अन्य [modes](../modes/index.md) के पूर्ण दस्तावेज़ीकरण के लिए [Predict](../modes/predict.md), [Train](../modes/train.md), [Val](../modes/val.md) और [Export](../modes/export.md) दस्तावेज़ों के पन्नों को देखें।

|

||||

|

||||

नीचे दिया गया उदाहरण YOLOv8 [Detect](../tasks/detect.md) मॉडल्स के लिए है, जो ऑब्जेक्ट डिटेक्शन के लिए हैं। अतिरिक्त समर्थित कार्यों के लिए [Segment](../tasks/segment.md), [Classify](../tasks/classify.md) और [Pose](../tasks/pose.md) दस्तावेज़ों को देखें।

|

||||

|

||||

!!! Example "उदाहरण"

|

||||

|

||||

=== "Python"

|

||||

|

||||

PyTorch पूर्व-प्रशिक्षित `*.pt` मॉडल और विन्यास `*.yaml` फ़ाइलों को पायथन में योगदान करने के लिए `YOLO()`, `SAM()`, `NAS()` और `RTDETR()` कक्षाओं को पास करके मॉडल की एक नमूना उत्पन्न की जा सकती है:

|

||||

पायथन में मॉडल बनाने के लिए PyTorch प्रीट्रेन्ड '*.pt' मॉडल्स के साथ-साथ कॉन्फ़िगरेशन '*.yaml' फ़ाइलों को `YOLO()`, `SAM()`, `NAS()` और `RTDETR()` क्लासेज़ में पास किया जा सकता है:

|

||||

|

||||

```python

|

||||

from ultralytics import YOLO

|

||||

|

||||

# एक COCO-पूर्व-प्रशिक्षित YOLOv8n मॉडल लोड करें

|

||||

# COCO-प्रीट्रेन्ड YOLOv8n मॉडल लोड करें

|

||||

model = YOLO('yolov8n.pt')

|

||||

|

||||

# मॉडल जानकारी प्रदर्शित करें (वैकल्पिक)

|

||||

# मॉडल की जानकारी दिखाएँ (वैकल्पिक)

|

||||

model.info()

|

||||

|

||||

# COCO8 उदाहरण डेटासेट पर मॉडल 100 एपॉक्स के लिए प्रशिक्षित करें

|

||||

# COCO8 उदाहरण डेटासेट पर 100 एपोक्स के लिए मॉडल प्रशिक्षित करें

|

||||

results = model.train(data='coco8.yaml', epochs=100, imgsz=640)

|

||||

|

||||

# YOLOv8n मॉडल के साथ 'bus.jpg' छवि पर इंफ़ेरेंस चलाएँ

|

||||

# 'bus.jpg' इमेज पर YOLOv8n मॉडल के साथ अनुमान चलाएँ

|

||||

results = model('path/to/bus.jpg')

|

||||

```

|

||||

|

||||

=== "CLI"

|

||||

|

||||

मॉडलों को सीधे चलाने के लिए CLI कमांड प्रदान किए गए हैं:

|

||||

CLI कमांड्स उपलब्ध हैं जो सीधे मॉडल्स को चलाने के लिए हैं:

|

||||

|

||||

```bash

|

||||

# एक COCO-पूर्व-प्रशिक्षित YOLOv8n मॉडल लोड करें और इसे COCO8 उदाहरण डेटासेट पर 100 एपॉक्स के लिए प्रशिक्षित करें

|

||||

# COCO-प्रीट्रेन्ड YOLOv8n मॉडल को लोड करें और COCO8 उदाहरण डेटासेट पर 100 एपोक्स के लिए प्रशिक्षित करें

|

||||

yolo train model=yolov8n.pt data=coco8.yaml epochs=100 imgsz=640

|

||||

|

||||

# एक COCO-पूर्व-प्रशिक्षित YOLOv8n मॉडल लोड करें और 'bus.jpg' छवि पर इंफ़ेरेंस चलाएँ

|

||||

# COCO-प्रीट्रेन्ड YOLOv8n मॉडल को लोड करें और 'bus.jpg' इमेज पर अनुमान चलाएँ

|

||||

yolo predict model=yolov8n.pt source=path/to/bus.jpg

|

||||

```

|

||||

|

||||

## नए मॉडल का योगदान देना

|

||||

## नए मॉडल्स का योगदान

|

||||

|

||||

Ultralytics में अपना मॉडल योगदान करने में रुचि है? शानदार! हमें हमेशा अपने मॉडल पोर्टफोलियो का विस्तार करने के लिए खुले दिमाग से आगे बढ़ने की आवश्यकता है।

|

||||

आप Ultralytics में अपने मॉडल का योगदान देने के इच्छुक हैं? बहुत बढ़िया! हम हमेशा अपने मॉडल पोर्टफोलियो का विस्तार करने के लिए खुले हैं।

|

||||

|

||||

1. **यहाँ से रिपॉजिटरी फोर्क करें**: सबसे पहले, [Ultralytics GitHub रिपॉजिटरी](https://github.com/ultralytics/ultralytics) को फोर्क करके शुरू करें।

|

||||

1. **रिपॉजिटरी फोर्क करें**: [Ultralytics GitHub रिपॉजिटरी](https://github.com/ultralytics/ultralytics) को फोर्क करके शुरू करें।

|

||||

|

||||

2. **अपने फोर्क को क्लोन करें**: अपने फोर्क को अपनी स्थानीय मशीन पर क्लोन करें और काम करने के लिए एक नया शाखा बनाएं।

|

||||

2. **अपने फोर्क को क्लोन करें**: अपने फोर्क को अपनी लोकल मशीन पर क्लोन करें और काम करने के लिए एक नई ब्रांच बनाएं।

|

||||

|

||||

3. **अपना मॉडल लागू करें**: अपना मॉडल उन्नत करें और Coding मानकों और दिशानिर्देशिकाओं का पालन करते हुए इसे जोड़ें। हमारे [योगदान गाइड](../../help/contributing.md) में उपलब्ध विवरणीय चरणों के लिए संपर्क करें।

|

||||

3. **अपना मॉडल लागू करें**: हमारे [Contributing Guide](../../help/contributing.md) में दिए गए कोडिंग स्टैंडर्ड्स और दिशानिर्देशों का अनुसरण करते हुए अपने मॉडल को जोड़ें।

|

||||

|

||||

4. **पूरी तरह से परीक्षण करें**: अपना मॉडल सम्पूर्ण रूप से औधोगिक रूप से परीक्षण करें, एकांत में और पाइपलाइन का हिस्सा के रूप में।

|

||||

4. **गहराई से परीक्षण करें**: अपने मॉडल का परीक्षण अलग से और पाइपलाइन के हिस्से के रूप में किया जा सकता है।

|

||||

|

||||

5. **एक पुल अनुरोध बनाएं**: अपने मॉडल से संतुष्ट होने के बाद, मुख्य रिपॉजिटरी के लिए एक पुल अनुरोध बनाएं जिसका समीक्षा की जाएगी।

|

||||

5. **पुल रिक्वेस्ट बनाएं**: एक बार जब आप अपने मॉडल से संतुष्ट हो जाएं, तो समीक्षा के लिए मुख्य रिपॉजिटरी को एक पुल रिक्वेस्ट बनाएं।

|

||||

|

||||

6. **कोड समीक्षा और मर्ज**: समीक्षा के बाद, यदि आपका मॉडल हमारे मानदंडों को पूरा करता है, तो यह मुख्य रिपॉजिटरी में मर्ज हो जाएगा।

|

||||

6. **कोड समीक्षा और मिलान**: समीक्षा के बाद, यदि आपका मॉडल हमारे मानदंडों को पूरा करता है, तो इसे मुख्य रिपॉजिटरी में मिला दिया जाएगा।

|

||||

|

||||

विस्तृत चरणों के लिए, हमारे [योगदान गाइड](../../help/contributing.md) पर देखें।

|

||||

विस्तृत चरणों के लिए हमारा [Contributing Guide](../../help/contributing.md) देखें।

|

||||

|

|

|

|||

115

docs/hi/models/mobile-sam.md

Normal file

115

docs/hi/models/mobile-sam.md

Normal file

|

|

@ -0,0 +1,115 @@

|

|||

---

|

||||

comments: true

|

||||

description: Ultralytics मार्गदर्शिका में MobileSAM के बारे में और उसके प्रायोगशाला तुलनात्मक विवेचन, मूल SAM के साथ तुलना और इसे Ultralytics ढांचे में डाउनलोड और परीक्षण कैसे करें। अपने मोबाइल ऐप्लिकेशन को बेहतर बनाएं।

|

||||

keywords: MobileSAM, Ultralytics, SAM, मोबाइल ऐप्लिकेशन, Arxiv, GPU, API, छवि एनकोडर, मास्क डिकोडर, मॉडल डाउनलोड, परीक्षण पद्धति

|

||||

---

|

||||

|

||||

|

||||

|

||||

# मोबाइल सेगमेंट कुछ भी (MobileSAM)

|

||||

|

||||

मोबाइलSAM पेपर [arXiv](https://arxiv.org/pdf/2306.14289.pdf) पर अब उपलब्ध है।

|

||||

|

||||

MobileSAM के संचालन का एक प्रदर्शन कम्प्यूटर पर पहुंचा जा सकता है उस [डेमो लिंक](https://huggingface.co/spaces/dhkim2810/MobileSAM) के माध्यम से। Mac i5 CPU पर प्रदर्शन करने में लगभग 3 सेकंड का समय लगता है। हगिंग फेस डेमो परिवेश और कम प्रदर्शन वाले सीपियू ने प्रतिक्रिया को धीमी किया है, लेकिन यह अभी भी प्रभावी ढंग से काम करता है।

|

||||

|

||||

मोबाइलSAM [Grounding-SAM](https://github.com/IDEA-Research/Grounded-Segment-Anything), [AnyLabeling](https://github.com/vietanhdev/anylabeling), और [Segment Anything in 3D](https://github.com/Jumpat/SegmentAnythingin3D) सहित विभिन्न परियोजनाओं में लागू है।

|

||||

|

||||

मोबाइलSAM एक एकल GPU पर 100k डेटासेट (मूल छवि का 1%) के साथ प्रशिक्षित होता है और इसमें एक दिन से कम समय लगता है। इस प्रशिक्षण के लिए कोड भविष्य में उपलब्ध कराया जाएगा।

|

||||

|

||||

## उपलब्ध मॉडल, समर्थित कार्य और ऑपरेटिंग मोड

|

||||

|

||||

इस तालिका में उपलब्ध मॉडल, उनके विशिष्ट पूर्व-प्रशिक्षित वजन, वे कार्य जिन्हें वे समर्थन करते हैं, और उनका अभिन्नतम संगतता के साथ विभिन्न ऑपरेटिंग मोड (इंफरेंस, वैधानिकी, प्रशिक्षण, और निर्यात) प्रदर्शित किए गए हैं, जिन्हें समर्थित मोड के लिए ✅ emoji और असमर्थित मोड के लिए ❌ emoji से दर्शाया गया है।

|

||||

|

||||

| मॉडल प्रकार | पूर्व-प्रशिक्षित वजन | समर्थित कार्य | इंफरेंस | वैधानिकी | प्रशिक्षण | निर्यात |

|

||||

|-------------|----------------------|--------------------------------------------|---------|----------|-----------|---------|

|

||||

| MobileSAM | `mobile_sam.pt` | [इंस्टेंस सेगमेंटेशन](../tasks/segment.md) | ✅ | ❌ | ❌ | ✅ |

|

||||

|

||||

## SAM से MobileSAM में अनुकूलन

|

||||

|

||||

MobileSAM मूल SAM की तरफ से समान पाइपलाइन बरकरार रखता है, हमने मूल की प्री-प्रोसेसिंग, पोस्ट-प्रोसेसिंग और सभी अन्य इंटरफेसों को सम्मिलित कर दिया है। इसलिए, वर्तमान में मूल SAM का उपयोग करने वाले लोग मिनिमल प्रयास के साथ MobileSAM में ट्रांसिशन कर सकते हैं।

|

||||

|

||||

MobileSAM मूल SAM के समान पाइपलाइन में उत्तम प्रदर्शन करता है और केवल छवि एन्कोडर में परिवर्तन होता है। विशेष रूप से, हम मूल भारीवज्ञानिक ViT-H एन्कोडर (632M) को एक छोटे Tiny-ViT (5M) से बदलते हैं। एकल GPU पर MobileSAM लगभग 12ms प्रति छवि पर ऑपरेट करता है: 8ms छवि एन्कोडर पर और 4ms मास्क डिकोडर पर।

|

||||

|

||||

विट-आधारित इमेज एन्कोडरों की तुलना नीचे दी गई तालिका प्रदान करती है:

|

||||

|

||||

| छवि एन्कोडर | मूल SAM | MobileSAM |

|

||||

|-------------|---------|-----------|

|

||||

| पैरामीटर्स | 611M | 5M |

|

||||

| स्पीड | 452ms | 8ms |

|

||||

|

||||

मूल SAM और MobileSAM दोनों में समान प्रॉम्प्ट गाइडेड मास्क डिकोडर का उपयोग किया गया है:

|

||||

|

||||

| मास्क डिकोडर | मूल SAM | MobileSAM |

|

||||

|--------------|---------|-----------|

|

||||

| पैरामीटर्स | 3.876M | 3.876M |

|

||||

| स्पीड | 4ms | 4ms |

|

||||

|

||||

यहां पाइपलाइन की तुलना है:

|

||||

|

||||

| पूरा पाइपलाइन (एन्कोडर+डिकोडर) | मूल SAM | MobileSAM |

|

||||

|--------------------------------|---------|-----------|

|

||||

| पैरामीटर्स | 615M | 9.66M |

|

||||

| स्पीड | 456ms | 12ms |

|

||||

|

||||

MobileSAM और मूल SAM के प्रदर्शन को एक बिन्दु और बॉक्स के रूप में प्रदर्शित किया जाता है।

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

बेहतर प्रदर्शन से MobileSAM मौजूदा FastSAM की तुलना में लगभग 5 गुना छोटा और 7 गुना तेज है। अधिक विवरण [MobileSAM प्रोजेक्ट पेज](https://github.com/ChaoningZhang/MobileSAM) पर उपलब्ध हैं।

|

||||

|

||||

## Ultralytics में MobileSAM का परीक्षण

|

||||

|

||||

मूल SAM की तरह ही, हम Ultralytics में एक सीधा परीक्षण विधि प्रदान करते हैं, जिसमें बिंदु और बॉक्स प्रॉम्प्ट्स दोनों के लिए मोड शामिल हैं।

|

||||

|

||||

### मॉडल डाउनलोड

|

||||

|

||||

आप यहां से मॉडल डाउनलोड कर सकते हैं [here](https://github.com/ChaoningZhang/MobileSAM/blob/master/weights/mobile_sam.pt)।

|

||||

|

||||

### बिंदु प्रॉम्प्ट

|

||||

|

||||

!!! Example "उदाहरण"

|

||||

|

||||

=== "Python"

|

||||

```python

|

||||

from ultralytics import SAM

|

||||

|

||||

# मॉडल लोड करें

|

||||

model = SAM('mobile_sam.pt')

|

||||

|

||||

# बिंदु प्रॉम्प्ट पर आधारित एक सेगमेंट पूर्वानुमान करें

|

||||

model.predict('ultralytics/assets/zidane.jpg', points=[900, 370], labels=[1])

|

||||

```

|

||||

|

||||

### बॉक्स प्रॉम्प्ट

|

||||

|

||||

!!! Example "उदाहरण"

|

||||

|

||||

=== "Python"

|

||||

```python

|

||||

from ultralytics import SAM

|

||||

|

||||

# मॉडल लोड करें

|

||||

model = SAM('mobile_sam.pt')

|

||||

|

||||

# बॉक्स प्रॉम्प्ट पर आधारित एक सेगमेंट पूर्वानुमान करें

|

||||

model.predict('ultralytics/assets/zidane.jpg', bboxes=[439, 437, 524, 709])

|

||||

```

|

||||

|

||||

हमने `MobileSAM` और `SAM` दोनों को एक ही API का उपयोग करके इम्प्लिमेंट किया है। अधिक उपयोग जानकारी के लिए, कृपया [SAM पेज](sam.md) देखें।

|

||||

|

||||

## संदर्भ और आभार

|

||||

|

||||

अगर आप अपने अनुसंधान या विकास कार्य में MobileSAM का उपयोगयोगी पाते हैं, तो कृपया हमारे पेपर को साइट करने का विचार करें:

|

||||

|

||||

!!! Quote ""

|

||||

=== "BibTeX"

|

||||

|

||||

```bibtex

|

||||

@article{mobile_sam,

|

||||

title={Faster Segment Anything: Towards Lightweight SAM for Mobile Applications},

|

||||

author={Zhang, Chaoning and Han, Dongshen and Qiao, Yu and Kim, Jung Uk and Bae, Sung Ho and Lee, Seungkyu and Hong, Choong Seon},

|

||||

journal={arXiv preprint arXiv:2306.14289},

|

||||

year={2023}

|

||||

}

|

||||

94

docs/hi/models/rtdetr.md

Normal file

94

docs/hi/models/rtdetr.md

Normal file

|

|

@ -0,0 +1,94 @@

|

|||

---

|

||||

comments: true

|

||||

description:

|

||||

Baidu के RT-DETR का अवलोकन करें: विज़न ट्रांसफॉर्मर के द्वारा संचालित, उन्नत और अनुकूलनयोग्य वास्तविक समय ऑब्जेक्ट डिटेक्टर, जिसमें तैयार मॉडल शामिल हैं।

|

||||

keywords: RT-DETR, Baidu, विज़न ट्रांसफॉर्मर्स, ऑब्जेक्ट डिटेक्शन, वास्तविक समय प्रदर्शन, CUDA, TensorRT, IoU-जागरूक क्वेरी चयन, Ultralytics, पायथन एपीआई, PaddlePaddle

|

||||

---

|

||||

|

||||

# Baidu के RT-DETR: एक विज़न ट्रांसफॉर्मर के आधार पर वास्तविक समय ऑब्जेक्ट डिटेक्टर

|

||||

|

||||

## अवलोकन

|

||||

|

||||

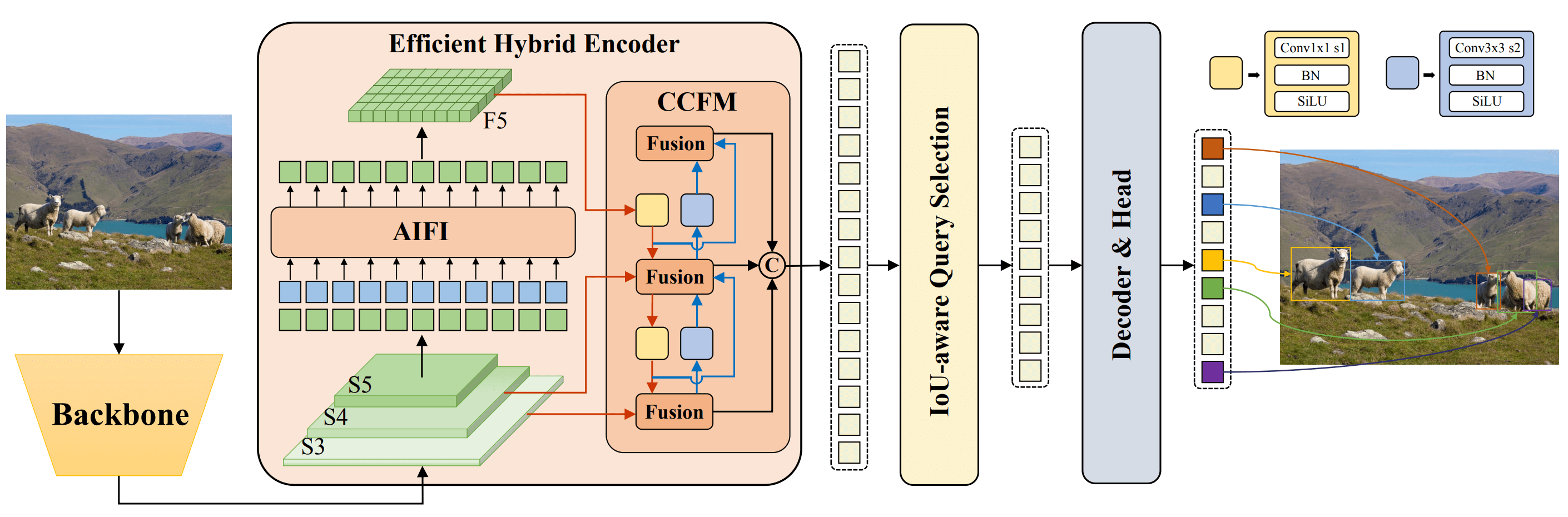

Baidu द्वारा विकसित रियल-टाइम डिटेक्शन ट्रांसफॉर्मर (RT-DETR) एक उन्नत, end-to-end ऑब्जेक्ट डिटेक्टर है जो उच्च नि: शुल्कता बनाए रखते हुए वास्तविक समय प्रदर्शन प्रदान करता है। यह Vision ट्रांसफॉर्मर्स (ViT) की शक्ति का उपयोग करके बहुस्तरीय सुविधाओं की कुशलतापूर्वक प्रोसेसिंग करता है और इंट्रा-स्केल इंटरेक्शन और क्रॉस-स्केल फ्यूजन को अलग करके विभिन्न मापों की सुविधा प्रदान करता है। RT-DETR अत्यधिक अनुकूलनयोग्य है, जिसमें ब्यावसायिक लिंग के विभिन्न डिकोडर लेयर का उपयोग करके उपन्यासात्मक गति को समायोजित करने की समर्थन की गई है बिना पुनर्प्रशिक्षण के। इस मॉडल का परिणामस्वरूप, जो कि CUDA और TensorRT के समर्थनयुक्त बैकेंड पर अच्छा क्रियाशील ऑब्जैक्ट डिटेक्टरों से अधिक प्रदर्शन करता है।

|

||||

|

||||

|

||||

**Baidu के RT-DETR का अवलोकन।** RT-DETR मॉडल आर्किटेक्चर आवचेदक जैसे आखिरी तीन स्टेज {S3, S4, S5} को इंपुट टू एन्कोडर के रूप में दर्शाता है। कटिहरण योग्य हाइब्रिड एन्कोडर अंत: धारण विशिष्टताओं को Ekत्रित और इंत्राक्ष स्थलीय लक्षण (AIFI) और क्रॉस-स्केल लक्षण-संघटन मॉड्यूल (CCFM) द्वारा चित्र विशेषण में परिवर्तित करता है। IoU-जागरूक क्वेरी चयन का उपयोग आदर्श छवि चयन के लिए निर्धारित संख्या के चित्र विशेषताओं को कवल वस्त्रण स्वरूप में चयनित करने के लिए किया जाता है। अंत में, डिकोडर सहायक पूर्वानुमान मुद्दा किसी विशेष छवि को उपयुक्त ऑब्जेक्ट क्वेरी के रूप में आरम्भ करने के लिए संशोधित किया जाता है जिसके अंत में बॉक्स और विश्वास स्कोर पैदा किया जाता है ([स्रोत](https://arxiv.org/pdf/2304.08069.pdf))।

|

||||

|

||||

### मुख्य विशेषताएँ

|

||||

|

||||

- **कटिहरण योग्य हाइब्रिड एन्कोडर:** Baidu के RT-DETR ने इंत्रा-स्केल इंटरेक्शन और क्रॉस-स्केल फ्यूजन को अलग करके बहुस्तरीय विशेषताओं को प्रोसेस करने के लिए एक कटिहरण योग्य हाइब्रिड एन्कोडर का उपयोग किया है। यह अद्वितीय विज़न ट्रांसफॉर्मर से आधिक हिमांशीय लागत को कम करता है और वास्तविक समय ऑब्जेक्ट डिटेक्शन की अनुमति देता है।

|

||||

- **IoU-जागरूक क्वेरी चयन:** Baidu के RT-DETR ने IoU-जागरूक क्वेरी चयन का उपयोग करके आदर्श छवि चयन को सुधारा है। इससे मॉडल द्वारा सीन में सबसे प्रासंगिक ऑब्जेक्ट पर केन्द्रित किया जा सकता है, जिससे डिटेक्शन की निशाना स्पष्टता में सुधार होती है।

|

||||

- **अनुकूलनयोग्य अनुमान प्रदान:** Baidu के RT-DETR ने पुनर्प्रशिक्षण के आवश्यकता के बिना भिन्न डिकोडर लेयर का उपयोग करके अनुमान की गति की मान्यता में सुविधाएं समर्थित की हैं। यह अनुकूलनयोग्यता वास्तविक समय ऑब्जेक्ट डिटेक्शन स्थितियों में व्यावहारिक लागू करने की सहायता करती है।

|

||||

|

||||

## प्री-तारकित मॉडल

|

||||

|

||||

Ultralytics Python API विभिन्न स्केलों के साथ प्री-तारकित PaddlePaddle RT-DETR मॉडल प्रदान करता है:

|

||||

|

||||

- RT-DETR-L: COCO val2017 पर 53.0% AP, T4 GPU पर 114 FPS

|

||||

- RT-DETR-X: COCO val2017 पर 54.8% AP, T4 GPU पर 74 FPS

|

||||

|

||||

## उपयोग उदाहरण

|

||||

|

||||

यह उदाहरण सरल RT-DETRR प्रशिक्षण और संदर्भ उदाहरण प्रदान करता है। पूरे दस्तावेज़ीकरण के लिए इन और अन्य [modes](../modes/index.md) पर देखें: [Predict](../modes/predict.md), [Train](../modes/train.md), [Val](../modes/val.md) और [Export](../modes/export.md) दस्तावेज़ पृष्ठों।

|

||||

|

||||

!!! Example "उदाहरण"

|

||||

|

||||

=== "पायथन"

|

||||

|

||||

```python

|

||||

from ultralytics import RTDETR

|

||||

|

||||

# COCO-प्री-तारकित RT-DETR-l मॉडल लोड करें

|

||||

model = RTDETR('rtdetr-l.pt')

|

||||

|

||||

# मॉडल जानकारी प्रदर्शित करें (वैकल्पिक)

|

||||

model.info()

|

||||

|

||||

# COCO8 उदाहरण डेटासेट पर मॉडल को 100 एपिसोड के लिए प्रशिक्षित करें

|

||||

results = model.train(data='coco8.yaml', epochs=100, imgsz=640)

|

||||

|

||||

# RT-DETR-l मॉडल के साथ 'bus.jpg' छवि पर संदर्भ चलाएं

|

||||

results = model('path/to/bus.jpg')

|

||||

```

|

||||

|

||||

=== "CLI"

|

||||

|

||||

```bash

|

||||

# COCO-प्री-तारकित RT-DETR-l मॉडल को लोड करें और उसे COCO8 उदाहरण डेटासेट पर 100 एपिसोड के लिए प्रशिक्षित करें

|

||||

yolo train model=rtdetr-l.pt data=coco8.yaml epochs=100 imgsz=640

|

||||

|

||||

# COCO-प्री-तारकित RT-DETR-l मॉडल को लोड करें और 'bus.jpg' छवि पर संदर्भ चलाएं

|

||||

yolo predict model=rtdetr-l.pt source=path/to/bus.jpg

|

||||

```

|

||||

|

||||

## समर्थित कार्य और मोड

|

||||

|

||||

इस तालिका में मॉडल प्रकार, विशेष प्री-तारकित भार, हर मॉडल द्वारा समर्थित कार्य, और [Train](../modes/train.md) , [Val](../modes/val.md), [Predict](../modes/predict.md), [Export](../modes/export.md) इत्यादि जैसे विभिन्न मोड्स विभाजित की गई हैं, ✅ इमोजियों द्वारा संकेतित हैं

|

||||

|

||||

| मॉडल प्रकार | प्री-तारकित भार | समर्थित कार्य | संदर्भ | मान्यता | प्रशिक्षण | निर्यात |

|

||||

|---------------------|-----------------|-----------------------------------------|--------|---------|-----------|---------|

|

||||

| RT-DETR Large | `rtdetr-l.pt` | [ऑब्जेक्ट डिटेक्शन](../tasks/detect.md) | ✅ | ✅ | ✅ | ✅ |

|

||||

| RT-DETR Extra-Large | `rtdetr-x.pt` | [ऑब्जेक्ट डिटेक्शन](../tasks/detect.md) | ✅ | ✅ | ✅ | ✅ |

|

||||

|

||||

## प्रशंसापत्र और आभार

|

||||

|

||||

यदि आप अपने शोध या विकास कार्य में Baidu के RT-DETR का उपयोग करते हैं, कृपया [मूल पेपर](https://arxiv.org/abs/2304.08069) को उद्धृत करें:

|

||||

|

||||

!!! Quote ""

|

||||

|

||||

=== "BibTeX"

|

||||

|

||||

```bibtex

|

||||

@misc{lv2023detrs,

|

||||

title={DETRs Beat YOLOs on Real-time Object Detection},

|

||||

author={Wenyu Lv and Shangliang Xu and Yian Zhao and Guanzhong Wang and Jinman Wei and Cheng Cui and Yuning Du and Qingqing Dang and Yi Liu},

|

||||

year={2023},

|

||||

eprint={2304.08069},

|

||||

archivePrefix={arXiv},

|

||||

primaryClass={cs.CV}

|

||||

}

|

||||

```

|

||||

|

||||

हम Baidu और [PaddlePaddle](https://github.com/PaddlePaddle/PaddleDetection) टीम को आभार प्रकट करना चाहेंगे जिन्होंने बिल्कुल लोक-दृष्टि समुदाय के लिए इस योग्य संसाधन को बनाने और संभालने का कार्य किया है। विज़न ट्रांसफॉर्मर्स-आधारित वास्तविक समय ऑब्जेक्ट डिटेक्टर RT-DETR के विकास के साथ उनके योगदान को बड़ा रूप से स्वीकार किया जाता है।

|

||||

|

||||

*Keywords: RT-DETR, ट्रांसफॉर्मर, ViT, विज़न ट्रांसफॉर्मर्स, Baidu RT-DETR, PaddlePaddle, PaddlePaddle RT-DETR, वास्तविक समय ऑब्जेक्ट डिटेक्शन, विज़न ट्रांसफॉर्मर्स आधारित ऑब्जेक्ट डिटेक्शन, प्री-तारकित PaddlePaddle RT-DETR मॉडल, Baidu के RT-DETR का उपयोग, Ultralytics Python API*

|

||||

226

docs/hi/models/sam.md

Normal file

226

docs/hi/models/sam.md

Normal file

|

|

@ -0,0 +1,226 @@

|

|||

---

|

||||

comments: true

|

||||

description: Ultralytics के Segment Anything Model (SAM) की अभिनव सेगमेंटेशन मॉडल का पता लगाएं जो रीयल-टाइम छवि सेगमेंटेशन की अनुमति देता है। समझें कि इसमें promptable सेगमेंटेशन, zero-shot प्रदर्शन शामिल है और यह कैसे उपयोग किया जाता है।

|

||||

keywords: Ultralytics, Image segmentation, Segment Anything Model, SAM, SA-1B डेटासेट, रीयल-टाइम प्रदर्शन, zero-shot ट्रांसफर, वस्तु पहचानन, छवि विश्लेषण, मशीन लर्निंग

|

||||

---

|

||||

|

||||

# Segment Anything Model (SAM)

|

||||

|

||||

Segment Anything Model (SAM), यानी वस्तु को के सिलसीलेबंद छवि सेगमेंटेशन के पहले खंड "SAM"में आपका स्वागत है। यह क्रांतिकारी मॉडल समयबद्ध प्रदर्शन के साथ promptable छवि सेगमेंटेशन द्वारा खेल को बदल चुका है और क्षेत्र में नई मानकों को स्थापित किए हैं।

|

||||

|

||||

## SAM: Segment Anything Model का परिचय

|

||||

|

||||

Segment Anything Model (SAM), यानी SAM, एक अभिनव छवि सेगमेंटेशन मॉडल है जो promptable सेगमेंटेशन की अनुमति देता है, जिससे छवि विश्लेषण कार्यों में अविश्वसनीय विविधता प्राप्त होती है। SAM, Segment Anything पहल के दिल में आता है, जो छवि सेगमेंटेशन के लिए नई मॉडल, कार्य और डेटासेट का परिचय कराता है।

|

||||

|

||||

SAM का उन्नत डिजाइन इसे नई छवि वितरणों और कार्यों के लिए पूर्वज्ञान के बिना सामायिक होने देता है, जिसे जीरो-शॉट ट्रांसफर के नाम से जाना जाता है। विस्तारशील [SA-1B डेटासेट](https://ai.facebook.com/datasets/segment-anything/) पर (जिसमें 1 अरब से अधिक मास्क हैं जो 11 मिलियन सावधानीपूर्वक इच्छीत छवियों पर बिखेरे गए हैं), SAM ने वास्तव में दिखाया है कि यह बेहद श्रेष्ठ जीरो-शॉट प्रदर्शन का anomaly-detection करने वाले पहले परिणामों को हर हाल में छू सकता है।

|

||||

|

||||

|

||||

हमारे नई पेशकश डेटासेट, SA-1B से दिए गए ओवरले मास्क वाली उदाहरण छवियाँ। SA-1B में 11M विविध, उच्च-रिजोल्यूशन, लाइसेंस और प्राइवेसी संरक्षण योग्य छवियाँ और 1.1B उच्च-गुणवत्ता वाले सेगमेंटेशन मास्क मौजूद हैं। इन मास्क को SAM द्वारा पूर्णतः स्वचालित रूप से टिप्पणी की गई हैं, और मानवीय रेटिंग और अनेक अभ्यासों से सत्यापित हुए अनुसार, इनकी गुणवत्ता और विविधता प्रमुख हैं। छवियों की संख्या के आधार पर छवियाँ समूहित की गई हैं (औसतन प्रति छवि पर लगभग 100 मास्क होती हैं)।

|

||||

|

||||

## Segment Anything Model (SAM) की मुख्य विशेषताएं

|

||||

|

||||

- **Promptable Segmentation Task:** SAM का निर्माण promptable सेगमेंटेशन कार्य के साथ किया गया है, जिसके बाद वह कोई भी प्रोम्प्ट देकर मान्य सेगमेंटेशन मास्क उत्पन्न कर सकता है, जैसे कि वस्तु का निर्देश करने वाले स्थानिक या पाठ संकेत।

|

||||

- **उन्नत वास्तविकता:** Segment Anything Model में एक शक्तिशाली छवि इनकोडर, प्रोम्प्ट इनकोडर, और हल्की वजन के मास्क डीकोडर की बाईं लगाम लगातार बदलाव और अस्पष्टता की जागरूकता पर आधारित होती है। यह विशेष आर्किटेक्चर प्रारंभिक जोखिम ज्ञान के बिना नए क्षेत्रों और छवि वितरणों के लिए सुविधाजनक होने की अनुमति देता है।

|

||||

- **SA-1B डेटासेट:** SAM पहल के द्वारा प्रस्तुत किए गए SA-1B डेटासेट में 11 मिलियन छवियों पर 1 अरब से अधिक मास्क होती हैं। इसे अब तक का सबसे बड़ा सेगमेंटेशन डेटासेट माना जाता है, जिससे SAM को विविधतापूर्ण और बड़े पैमाने पर भड़ास ट्रेनिंग डेटा स्रोत प्राप्त होता है।

|

||||

- **जीरो-शॉट प्रदर्शन:** SAM विभिन्न सेगमेंटेशन कार्यों में उत्कृष्ट जीरो-शॉट प्रदर्शन प्रदर्शित करता है, जिससे यह विविध अनुप्रयोगों के लिए तत्परता के आवश्यकता के साथ तत्परता के यन्त्रियों के लिए तत्परता के यंत्रों के लिए तत्पर करने योग्य एक तत्परता यंत्र बन गया है।

|

||||

|

||||

Segment Anything Model और SA-1B डेटासेट की गहन जानकारी के लिए, कृपया [Segment Anything वेबसाइट](https://segment-anything.com) पर जाएं और शोध पेपर [Segment Anything](https://arxiv.org/abs/2304.02643) की जाँच करें।

|

||||

|

||||

## उपलब्ध मॉडल, समर्थित कार्य और संचालनिक विधियाँ

|

||||

|

||||

यह तालिका उपलब्ध मॉडल, उनकी विशेष पूर्व-प्रशिक्षित वेट, उनके समर्थित कार्य और इंफरेंस, मान्यीकरण, प्रशिक्षण और निर्यात जैसे विभिन्न संचालित विधियों के साथ उनकी संबद्धता का प्रस्ताव प्रस्तुत करती है.

|

||||

|

||||

| मॉडल प्रकार | पूर्व-प्रशिक्षित वेट | समर्थित कार्य | Inference | Validation | Training | Export |

|

||||

|-------------|----------------------|---------------------|-----------|------------|----------|--------|

|

||||

| SAM बेस | `sam_b.pt` | इंस्टेंस सेगमेंटेशन | ✅ | ❌ | ❌ | ✅ |

|

||||

| SAM लार्ज | `sam_l.pt` | इंस्टेंस सेगमेंटेशन | ✅ | ❌ | ❌ | ✅ |

|

||||

|

||||

## SAM का उपयोग कैसे करें: छवि सेगमेंटेशन में यथार्थता और शक्ति

|

||||

|

||||

Segment Anything Model का उपयोग उपस्थित डेटा से आगे के कार्यों के लिए किया जा सकता है। इसमें एज डिटेक्शन, निवेदन प्रस्ताव उत्पादन, इंस्टेंस सेगमेंटेशन, और प्राथमिक पाठ-तो-मास्क पूर्वानुमान शामिल हैं। प्रोम्प्ट इंजीनियरिंग के साथ, SAM नए कार्यों और डेटा वितरणों के लिए जीरो-शॉट तरीके में शीघ्र रूप से अनुकूलित हो सकता है, जिससे यह आपकी सभी छवि सेगमेंटेशन आवश्यकताओं के लिए एक सुगम और प्रभावी उपकरण बन जाता है।

|

||||

|

||||

### SAM पूर्वानुमान उदाहरण

|

||||

|

||||

!!! Example "निर्दिष्ट प्रप्ति के साथ सेगमेंट तय करें"

|

||||

|

||||

निर्दिष्ट प्रप्ति के साथ चित्रीय भविष्यवाणी करें।

|

||||

|

||||

=== "टख्ती"

|

||||

|

||||

```python

|

||||

from ultralytics import SAM

|

||||

|

||||

# एक मॉडल लोड करें

|

||||

model = SAM('sam_b.pt')

|

||||

|

||||

# मॉडल सूचना प्रदर्शित करें (वैकल्पिक)

|

||||

model.info()

|

||||

|

||||

# बॉक्स प्रम्प्ट के साथ इनफ़रन्स चलाएं

|

||||

model('ultralytics/assets/zidane.jpg', bboxes=[439, 437, 524, 709])

|

||||

|

||||

# बिंदु प्रम्प्ट के साथ इनफ़रन्स चलाएं

|

||||

model('ultralytics/assets/zidane.jpg', points=[900, 370], labels=[1])

|

||||

```

|

||||

|

||||

!!! Example "सब कुछ सेगमेंट करें"

|

||||

|

||||

पूरी छवि को सेगमेंट करें।

|

||||

|

||||

=== "टख्ती"

|

||||

|

||||

```python

|

||||

from ultralytics import SAM

|

||||

|

||||

# एक मॉडल लोड करें

|

||||

model = SAM('sam_b.pt')

|

||||

|

||||

# मॉडल सूचना प्रदर्शित करें (वैकल्पिक)

|

||||

model.info()

|

||||

|

||||

# इनफ़रेंस चलाएं

|

||||

model('पथ/फ़ाइल/सदृश छवि.जेपीजी')

|

||||

```

|

||||

|

||||

=== "CLI"

|

||||

|

||||

```बैश

|

||||

# सब कुछ SEKैग के साथ SAM मॉडल के साथ इनफ़रन्स चलाएं

|

||||

yolo predict model=sam_b.pt source=पथ/फ़ाइल/सदृश छवि.जेपीजी

|

||||

```

|

||||

|

||||

- यहां यह तर्क है कि आप प्रोम्प्ट (बॉक्स / पॉइंट / मास्क) पास नहीं करते हैं तो पूरी छवि को सेगमेंट करें।

|

||||

|

||||

!!! Example "SAMPredictor उदाहरण"

|

||||

|

||||

इस तरह से आप एक बार छवि सेट कर सकते हैं और बार-बार प्रोम्प्ट इन्फ़रेंस चला सकते हैं। छवि को बार बार इन्कोडर के मध्य में नहीं चलाने के लिए।

|

||||

|

||||

=== "प्रोम्प्ट भविष्यवाणी करना"

|

||||

|

||||

```python

|

||||

from ultralytics.models.sam import Predictor as SAMPredictor

|

||||

|

||||

# SAMPredictor बनाएं

|

||||

overrides = dict(conf=0.25, task='कटा', mode='पूर्वानुमान', imgsz=1024, model="mobile_sam.pt")

|

||||

predictor = SAMPredictor(overrides=overrides)

|

||||

|

||||

# चित्र सेट करें

|

||||

predictor.set_image("ultralytics/assets/zidane.jpg") # चित्र फ़ाइल के साथ सेट करें

|

||||

predictor.set_image(cv2.imread("ultralytics/assets/zidane.jpg")) # एनपी. एस. एन. द्वारा सेट करें

|

||||

results = predictor(bboxes=[439, 437, 524, 709])

|

||||

results = predictor(points=[900, 370], labels=[1])

|

||||

|

||||

# चित्र रीसेट करें

|

||||

predictor.reset_image()

|

||||

```

|

||||

|

||||

अतिरिक्त तत्वों के साथ सब कुछ को टुकड़ों में विभाजित करें।

|

||||

|

||||

=== "सब कुछ का सेगमेंट"

|

||||

|

||||

```python

|

||||

from ultralytics.models.sam import Predictor as SAMPredictor

|

||||

|

||||

# SAMPredictor बनाएं

|

||||

overrides = dict(conf=0.25, task='सेगमेंट', mode='पूर्वानुमान', imgsz=1024, model="mobile_sam.pt")

|

||||

predictor = SAMPredictor(overrides=overrides)

|

||||

|

||||

# अतिरिक्त तत्वों के साथ सेगमेंट

|

||||

results = predictor(source="ultralytics/assets/zidane.jpg", crop_n_layers=1, points_stride=64)

|

||||

```

|

||||

|

||||

- `सब कुछ का सेगमेंट` के लिए अतिरिक्त तत्वों के लिए अधिक देखें [`Predictor/generate` Reference](../../reference/models/sam/predict.md).

|

||||

|

||||

## SAM की तुलना YOLOv8 के बनाम

|

||||

|

||||

यहां हम SAM के सबसे छोटे मॉडल, SAM-b, की तुलना Ultralytics के सबसे छोटे सेगमेंट मॉडल, [YOLOv8n-seg](../टास्क/सेगमेंट.md), के साथ करते हैं:

|

||||

|

||||

| मॉडल | आकार | पैरामीटर | गति (सीपीयू) |

|

||||

|--------------------------------------------------------------------|-----------------------------|----------------------|-------------------------|

|

||||

| SAM का सबसे छोटा, SAM-b | 358 MB | 94.7 M | 51096 ms/im |

|

||||

| [मोबाइल SAM](mobile-sam.md) | 40.7 MB | 10.1 M | 46122 ms/im |

|

||||

| [अग्री सेगमेंटेशन वाली FastSAM-s, YOLOv8 बैकबोन सहित](fast-sam.md) | 23.7 MB | 11.8 M | 115 ms/im |

|

||||

| Ultralytics [योलोवी8न-seg](../टास्क/सेगमेंट.md) | **6.7 MB** (53.4 गुना छोटा) | **3.4 M** (27.9x कम) | **59 ms/im** (866x तेज) |

|

||||

|

||||

यह तुलना मॉडल के आकार और गति में दस्तावेजीय अंतर दिखाती है। जहां SAM स्वचालित सेगमेंटेशन के लिए अद्वितीय क्षमताओं को प्रस्तुत करता है, वहीं Ultralytics विद्यमान सेगमेंटेशन मानदंडों के तुलनात्मक आकार, गति और संचालन क्षमता में समर्थन प्रदान करती है।

|

||||

|

||||

एक 2023 Apple M2 Macbook (16GB रैम के साथ) पर चलाई गई परीक्षा। इस परीक्षण को दोहराने के लिए:

|

||||

|

||||

!!! Example "उदाहरण"

|

||||

|

||||

=== "Python"

|

||||

```python

|

||||

from ultralytics import FastSAM, SAM, YOLO

|

||||

|

||||

# SAM-b प्रोफाइल करें

|

||||

model = SAM('sam_b.pt')

|

||||

model.info()

|

||||

model('ultralytics/assets')

|

||||

|

||||

# मोबाइलSAM प्रोफाइल करें

|

||||

model = SAM('mobile_sam.pt')

|

||||

model.info()

|

||||

model('ultralytics/assets')

|

||||

|

||||

# FastSAM-s प्रोफाइल करें

|

||||

model = FastSAM('FastSAM-s.pt')

|

||||

model.info()

|

||||

model('ultralytics/assets')

|

||||

|

||||

# YOLOv8n-seg प्रोफाइल करें

|

||||

model = YOLO('yolov8n-seg.pt')

|

||||

model.info()

|

||||

model('ultralytics/assets')

|

||||

```

|

||||

|

||||

## स्वत: टिपण्णीकरण: सेगमेंटेशन डेटासेट के लिए एक त्वरित मार्ग

|

||||

|

||||

स्वत: टिपण्णीकरण SAM की एक मुख्य सुविधा है जो उपयोगकर्ताओं को एक पूर्व-प्रशिक्षित डिटेक्शन मॉडल का उपयोग करके [सेगमेंटेशन डेटासेट](https://docs.ultralytics.com/datasets/segment) उत्पन्न करने की अनुमति देती है। यह सुविधा बड़ी संख्या में छवियों को क्वालिटी कंट्रोल से आनोत करने की जरूरत के दौरान समयरोकी मूल्य अंकन की जरूरत छोड़ती है।

|

||||

|

||||

### अपने सेगमेंटेशन डेटासेट के उपयोग के लिए गतिशीलता निर्मित करें

|

||||

|

||||

Ultralytics फ़्रेमवर्क के साथ स्वस्थ दिखाई देने वाले वर्गानुसार [सेगमेंटेशन डेटासेट](https://docs.ultralytics.com/datasets/segment) बनाएं। एपनी में दिए गए आदेश का उपयोग करके।

|

||||

|

||||

!!! Example "उदाहरण"

|

||||

|

||||

=== "Python"

|

||||

```python

|

||||

from ultralytics.data.annotator import auto_annotate

|

||||

|

||||

auto_annotate(data="पथ/सामग्री", det_model="yolov8x.pt", sam_model='sam_b.pt')

|

||||

```

|

||||

|

||||

| तत्व | प्रकार | विवरण | डिफ़ॉल्ट |

|

||||

|------------|-------------------|--------------------------------------------------------------------------------------------------------------------------------------------|--------------|

|

||||

| डेटा | str | अनुमानित मूल छवियाँ जो आंशिक प्रतिसादान के लिए अनुमानित हैं। | |

|

||||

| det_model | str, वैकल्पिक | पूर्व-प्रशिक्षित YOLO डिटेक्शन मॉडल। 'yolov8x.pt' डिफ़ॉल्ट रूप से होता है। | 'yolov8x.pt' |

|

||||

| sam_model | str, वैकल्पिक | पूर्व-प्रशिक्षित SAM सेगमेंटेशन मॉडल। डिफ़ॉल्ट रूप से 'sam_b.pt' है। | 'sam_b.pt' |

|

||||

| device | str, वैकल्पिक | मॉडल को चलाने के लिए डिवाइस। डिफ़ॉल्ट रूप से एक खाली स्ट्रिंग होता है (सीपीयू या जीपीयू, यदि उपलब्ध है)। | |

|

||||

| output_dir | str, कोई वैकल्पिक | टिपण्णीत परिणाम सहेजने के लिए निर्देशिका। इसे 'डेटा' के समान डिरेक्टरी में "निर्देशिकाएं" निर्दिष्ट करने के लिए डिफ़ॉल्ट मान नहीं होता है। | कोई |

|

||||

|

||||

`ऑटो_तिपण्णी` फ़ंक्शन आपकी छवियों के लिए यातायात का कार्यक्रम देखती है और सेगमेंटेशन सेट को आपके छवि के पथ सेट करती है, वैकल्पिक तत्वों के लिए पूर्व-प्रशिक्षित डिटेक्शन और SAM सेगमेंटेशन मॉडल, मॉडल को चलाने के लिए डिवाइस और टिपण्णीत परिणाम सहेजने के लिए निर्देशिका जैसे, इन कार्यक्रम तत्वों का उपयोग करते हुए।

|

||||

|

||||

पूर्व-प्रशिक्षित मॉडल के साथ स्वत: टिपण्णीकरण छवि एनोटेशन एक बड़े पैमाने पर सेगमेंटेशन डेटासेट बनाने के लिए प्रायोगिक और ऊर्जावान उपकारण है। यह सुविधा विशेष रूप से उस समय सुरेखितह रेखांकीकरण के लिए समय-शीघ्रता द्वारा तय कार्यों के साथ, उच्च गुणवत्ता वाले सेगमेंटेशन डेटासेट बनाने के लिए अधिक जरूरी होता है। इस सुविधा का उद्देश्यसिद्ध उपयोगकर्ताओं और डेवलपर्स के लिए विद्यमान छवि संग्रहों के साथ जटिल सूक्ष्म मॉडल विकास और मान्यानुयोग का महत्वपूर्ण विकल्प प्रदान करती है।

|

||||

|

||||

## प्रशंसा और आभार

|

||||

|

||||

यदि आप अपने शोध या विकास के लिए SAM का उपयोगकर्ता करते हैं, तो कृपया हमारे पेपर को उदाहरणित करने को विचार करें:

|

||||

|

||||

!!! Quote ""

|

||||

|

||||

=== "BibTeX"

|

||||

|

||||

```bibtex

|

||||

@misc{kirillov2023segment,

|

||||

title={Segment Anything},

|

||||

author={Alexander Kirillov and Eric Mintun and Nikhila Ravi and Hanzi Mao and Chloe Rolland and Laura Gustafson and Tete Xiao and Spencer Whitehead and Alexander C. Berg and Wan-Yen Lo and Piotr Dollár and Ross Girshick},

|

||||

year={2023},

|

||||

eprint={2304.02643},

|

||||

archivePrefix={arXiv},

|

||||

primaryClass={cs.CV}

|

||||

}

|

||||

```

|

||||

|

||||

हम कंप्यूटर विज्ञान समुदाय के लिए इस मूल्यवान संसाधन को निर्मित और बनाए रखने के लिए तारीफ करना चाहेंगे।

|

||||

|

||||

*संकेत: Segment Anything, Segment Anything Model, समुद्री, Meta SAM, छवि सेगमेंटेशन, promptable सेगमेंटेशन, zero-shot प्रदर्शन, SA-1B डेटा सेट, उन्नत आर्किटेक्चर, स्वत: टिपण्णीकरण, Ultralytics, पूर्व-प्रशिक्षित मॉडलें, SAM बेस, SAM-लार्ज, इंस्टेंस सेगमेंटेशन, कंप्यूटर विज्ञान, AI, artificial intelligence, machine learning, data annotation, segmentation masks, डिटेक्शन मॉडल, YOLO डिटेक्शन मॉडल, bibtex, Meta AI.

|

||||

119

docs/hi/models/yolo-nas.md

Normal file

119

docs/hi/models/yolo-nas.md

Normal file

|

|

@ -0,0 +1,119 @@

|

|||

---

|

||||

comments: true

|

||||

description: YOLO-NAS एक बेहतर वस्तु पहचान मॉडल है। इसकी विशेषताएँ, प्री-प्रशित मॉडल, Ultralytics Python API के साथ उपयोग और अधिक के बारे में विस्तृत दस्तावेज़ीकरण जानें।

|

||||

keywords: YOLO-NAS, Deci AI, object detection, deep learning, neural architecture search, Ultralytics Python API, YOLO model, pre-trained models, quantization, optimization, COCO, Objects365, Roboflow 100

|

||||

---

|

||||

|

||||

# YOLO-NAS

|

||||

|

||||

## अवलोकन

|

||||

|

||||

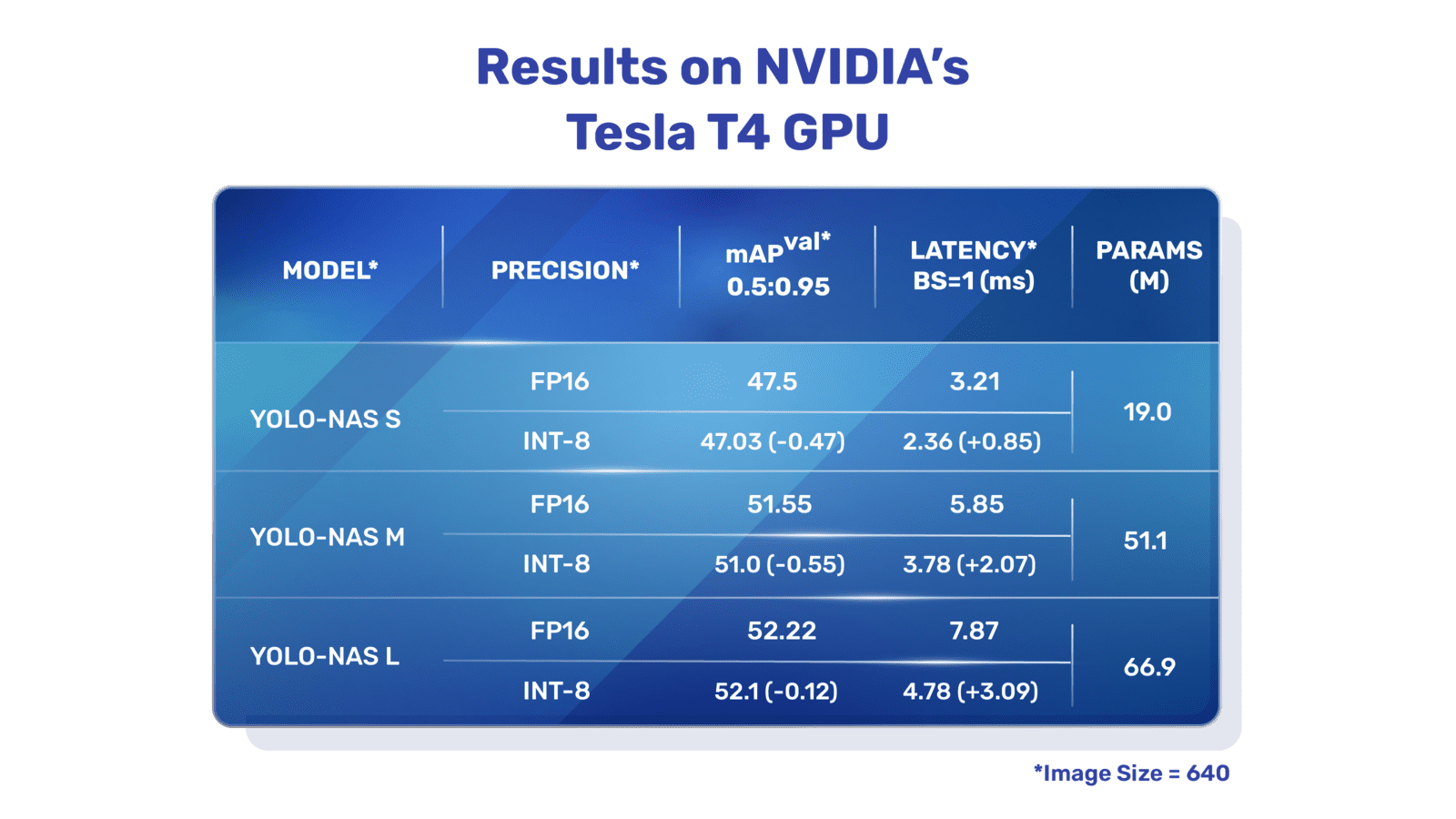

डेसी एआई द्वारा विकसित YOLO-NAS एक महत्वपूर्ण वस्तु पहचान मूलभूत मॉडल है। यह पिछले YOLO मॉडलों की सीमाओं का समाधान करने के लिए मानकर्मशास्त्रीय संरचना खोज प्रौद्योगिकी का उत्पाद है। क्वांटाइज़ेशन समर्थन और सटीकता-लेटेंसी विनिमय में काफी सुधार के साथ, YOLO-NAS वस्तु पहचान में एक महत्वपूर्ण आगे की लड़ाई प्रस्तुत करता है।

|

||||

|

||||

|

||||

**YOLO-NAS का अवलोकन।** YOLO-NAS आपेक्षिकता के लिए ब्लॉक्स और वैकल्पिक क्वांटाइज़ेशन के साथ क्वांटाइज़ेशन योग्य ब्लॉक का उपयोग करता है। मॉडल को INT8 क्वांटाइज़ेशन में रूपांतरित किया जाने पर, अन्य मॉडलों की तुलना में केवल थोड़ी सी सटीकता नुकसान होती है। ये उन्नति सभी विकसित विशेषताओं द्वारा योग्यतापूर्वक वस्तु पहचान क्षमताओं और अद्वितीय प्रदर्शन में समाप्त होती है।

|

||||

|

||||

### मुख्य विशेषताएँ

|

||||

|

||||

- **क्वांटाइज़ेशन-मित्रशील मूल ब्लॉक:** YOLO-NAS पिछले YOLO मॉडलों की एक महत्वपूर्ण सीमा को समाप्त करने के लिए एक नया मूल ब्लॉक पेश करता है।

|

||||

- **सुरुचिपूर्वक प्रशिक्षण और क्वांटाइज़ेशन:** YOLO-NAS उन्नत प्रशिक्षण योजनाएं और पोस्ट-प्रशिक्षण क्वांटाइज़ेशन का उपयोग करता है ताकि प्रदर्शन में सुधार हो सके।

|

||||

- **ऑटोएनएसी अनुकूलन और प्री-प्रशित:** YOLO-NAS ऑटोएनएसी अनुकूलन का उपयोग करता है और COCO, Objects365 और Roboflow 100 जैसे प्रमुख डेटासेटों पर प्री-प्रशित होता है। यह प्री-प्रशित इसे उत्पादन वातावरण में नीचे पड़ने वाले वस्तु पहचान कार्यों के लिए अत्यंत उपयुक्त बनाता है।

|

||||

|

||||

## प्री-प्रशित मॉडल

|

||||

|

||||

Ultralytics द्वारा प्रदान की गई प्री-प्रशित YOLO-NAS मॉडल के साथ आगामी पीढ़ी की वस्तु पहचान की शक्ति का अनुभव करें। ये मॉडल स्पीड और सटीकता दोनों में उत्कृष्ट प्रदर्शन करने के लिए डिज़ाइन किए गए हैं। अपनी विशिष्ट आवश्यकताओं के लिए विभिन्न विकल्पों में से चुनें:

|

||||

|

||||

| मॉडल | mAP | लेटेंसी (मिलीसेकंड) |

|

||||

|------------------|-------|---------------------|

|

||||

| YOLO-NAS S | 47.5 | 3.21 |

|

||||

| YOLO-NAS M | 51.55 | 5.85 |

|

||||

| YOLO-NAS L | 52.22 | 7.87 |

|

||||

| YOLO-NAS S INT-8 | 47.03 | 2.36 |

|

||||

| YOLO-NAS M INT-8 | 51.0 | 3.78 |

|

||||

| YOLO-NAS L INT-8 | 52.1 | 4.78 |

|

||||

|

||||

प्रत्येक मॉडल वेरिएंट mAP और लेटेंसी के बीच संतुलन का प्रस्ताव करने के लिए डिज़ाइन किए गए हैं, जो आपके वस्तु पहचान कार्यों को प्रदर्शन और गति दोनों के लिए आपकी आवश्यकताओं के लिए अनुकूलित करने में मदद करेगा।

|

||||

|

||||

## उपयोग उदाहरण

|

||||

|

||||

Ultralytics ने YOLO-NAS मॉडलों को आपके Python ऐप्लिकेशन में आसानी से एकीकृत करने के लिए हमारे `ultralytics` पाइथन पैकेज के माध्यम से सुविधाजनक पायथन API प्रदान किया है। पैकेज प्रक्रिया को सुगठित करने के लिए एक उपयोगकर्ता-मित्रपूर्ण पाइथन API प्रदान करता है।

|

||||

|

||||

निम्न उदाहरण दिखाते हैं कि `उल्ट्रालिटिक्स` पैकेज के साथ YOLO-NAS मॉडलों का उपयोग `ultralytics` पैकेज के साथ कैसे करें:

|

||||

|

||||

### पहचान और मान्यता उदाहरण

|

||||

|

||||

इस उदाहरण में हम COCO8 डेटासेट पर YOLO-NAS-s की मान्यता करते हैं।

|

||||

|

||||

!!! Example "उदाहरण"

|

||||

|

||||

इस उदाहरण में हम YOLO-NAS के लिए सरल पहचान और मान्यता कोड प्रदान करते हैं। पहचान परिणामों का हैंडलिंग करने के लिए देखें [भविष्यवाणी](../प्राथमिकताएँ/भविष्यवाणी.md) मोड को। अतिरिक्त मोड के साथ YOLO-NAS का उपयोग करने के लिए [मान्यता](../प्राथमिकताएँ/मान्यता.md) और [निर्यात](../प्राथमिकताएँ/निर्यात.md) को देखें। `उल्ट्रालिटिक्स` पैकेज पर YOLO-NAS का प्रशिक्षण समर्थन नहीं करती है।

|

||||

|

||||

=== "Python"

|

||||

|

||||

PyTorch प्री-प्रशित `*.pt` मॉडल फ़ाइलों को उल्ट्रालिटिक्स क्लास 'नास()' को पास किया जा सकता है ताकि पायथन में एक मॉडल मामला बनाया जा सके:

|

||||

|

||||

```python

|

||||

from ultralytics import NAS

|

||||

|

||||

# COCO-pretrained YOLO-NAS-s मॉडल लोड करें

|

||||

model = NAS('yolo_nas_s.pt')

|

||||

|

||||

# मॉडल की जानकारी दिखाएँ (वैकल्पिक)

|

||||

model.info()

|

||||

|

||||

# COCO8 उदाहरण डेटासेट पर मॉडल की मान्यता करें

|

||||

results = model.val(data='coco8.yaml')

|

||||

|

||||

# 'bus.jpg' छवि पर YOLO-NAS-s मॉडल के साथ पहचान चलाएं

|

||||

results = model('path/to/bus.jpg')

|

||||

```

|

||||

|

||||

=== "CLI"

|

||||

|

||||

मॉडलों को सीधे चलाने के लिए CLI कमांड उपलब्ध हैं:

|

||||

|

||||

```bash

|

||||

# COCO-pretrained YOLO-NAS-s मॉडल लोड करें और उसकी प्रदर्शन मान्यता करें COCO8 उदाहरण डेटासेट पर

|

||||

yolo val model=yolo_nas_s.pt data=coco8.yaml

|

||||

|

||||

# COCO-pretrained YOLO-NAS-s मॉडल लोड करें और 'bus.jpg' छवि पर पहचान चलाएं

|

||||

yolo predict model=yolo_nas_s.pt source=path/to/bus.jpg

|

||||

```

|

||||

|

||||

## समर्थित कार्य और मोड

|

||||

|

||||

हम तीन YOLO-NAS मॉडल वेरिएंट प्रदान करते हैं: छोटा (s), मध्यम (m) और बड़ा (l)। प्रत्येक वेरिएंट विभिन्न कंप्यूटेशनल और प्रदर्शन आवश्यकताओं के लिए डिज़ाइन किए गए हैं:

|

||||

|

||||

- **YOLO-NAS-s**: कम्प्यूटेशन संसाधन सीमित होते हैं लेकिन दक्षता महत्वपूर्ण हैं, ऐसे वातावरणों के लिए अनुकूलित।

|

||||

- **YOLO-NAS-m**: एक संतुलित दृष्टिकोण प्रदान करता है, जिससे आपके पास उच्च सटीकता वाले सामान्य-उद्देश्य वस्तु पहचान के लिए उपयुक्तता होती है।

|

||||

- **YOLO-NAS-l**: सबसे अधिक सटीकता की आवश्यकता होने वाले स्थितियों के लिए विशेष रूप से तैयार किया जाता है, जहां गणना संसाधनों की कम बाधा होती है।

|

||||

|

||||

नीचे प्रत्येक मॉडल के बारे में एक विस्तृत अवलोकन दिया गया है, जिसमें उनकी प्री-प्रशित वेट, ये कार्य समर्थित करते हैं, और इनकी आपरेटिंग मोड के साथ उनका संगतता शामिल है।

|

||||

|

||||

| मॉडल प्रकार | प्री-प्रशित वेट | समर्थित कार्य | पहचान | मान्यता | प्रशिक्षण | निर्यात |

|

||||

|-------------|-----------------------------------------------------------------------------------------------|----------------------------------------|-------|---------|-----------|---------|

|

||||

| YOLO-NAS-s | [yolo_nas_s.pt](https://github.com/ultralytics/assets/releases/download/v0.0.0/yolo_nas_s.pt) | [वस्तु पहचान](../कार्य/चित्र_पहचान.md) | ✅ | ✅ | ❌ | ✅ |

|

||||

| YOLO-NAS-m | [yolo_nas_m.pt](https://github.com/ultralytics/assets/releases/download/v0.0.0/yolo_nas_m.pt) | [वस्तु पहचान](../कार्य/चित्र_पहचान.md) | ✅ | ✅ | ❌ | ✅ |

|

||||

| YOLO-NAS-l | [yolo_nas_l.pt](https://github.com/ultralytics/assets/releases/download/v0.0.0/yolo_nas_l.pt) | [वस्तु पहचान](../कार्य/चित्र_पहचान.md) | ✅ | ✅ | ❌ | ✅ |

|

||||

|

||||

## उद्धरण और प्रशंसापत्र

|

||||

|

||||

यदि आप अपने शोध या विकास कार्य में YOLO-NAS का उपयोग करते हैं, कृपया SuperGradients को उद्धरण दें:

|

||||

|

||||

!!! Quote ""

|

||||

|

||||

=== "BibTeX"

|

||||

|

||||

```bibtex

|

||||

@misc{supergradients,

|

||||

doi = {10.5281/ZENODO.7789328},

|

||||

url = {https://zenodo.org/record/7789328},

|

||||

author = {Aharon, Shay and {Louis-Dupont} and {Ofri Masad} and Yurkova, Kate and {Lotem Fridman} and {Lkdci} and Khvedchenya, Eugene and Rubin, Ran and Bagrov, Natan and Tymchenko, Borys and Keren, Tomer and Zhilko, Alexander and {Eran-Deci}},

|

||||

title = {Super-Gradients},

|

||||

publisher = {GitHub},

|

||||

journal = {GitHub repository},

|

||||

year = {2021},

|

||||

}

|

||||

```

|

||||

|

||||

हम Deci AI के [SuperGradients](https://github.com/Deci-AI/super-gradients/) टीम के प्रयासों के लिए आभार प्रकट करते हैं जिन्होंने इस महत्वपूर्ण संसाधन को बनाने और बनाए रखने के लिए। हम मानते हैं कि YOLO-NAS, अपने नवाचारी श्रेणीबद्ध संरचना और उत्कृष्ट वस्तु पहचान क्षमताओं के साथ एक महत्वपूर्ण उपकरण बनेगा जिसे उद्यमियों और शोधकर्ताओं के लिए आवश्यक साधन बना रखा जाएगा।

|

||||

98

docs/hi/models/yolov3.md

Normal file

98

docs/hi/models/yolov3.md

Normal file

|

|

@ -0,0 +1,98 @@

|

|||

---

|

||||

comments: true

|

||||

description: YOLOv3, YOLOv3-Ultralytics और YOLOv3u के बारे में जानें। इनकी प्रमुख विशेषताएँ, उपयोग और वस्तु डिटेक्शन के लिए समर्थित कार्यों की जानकारी प्राप्त करें।

|

||||

keywords: YOLOv3, YOLOv3-Ultralytics, YOLOv3u, वस्तु डिटेक्शन, इनफेरेन्स, प्रशिक्षण, Ultralytics

|

||||

---

|

||||

|

||||

# YOLOv3, YOLOv3-Ultralytics, और YOLOv3u

|

||||

|

||||

## सवाल

|

||||

|

||||

ये प्रदर्शनी में तीन प्रमुख वस्तु डिटेक्शन मॉडलों, यानी [YOLOv3](https://pjreddie.com/darknet/yolo/), [YOLOv3-Ultralytics](https://github.com/ultralytics/yolov3) और [YOLOv3u](https://github.com/ultralytics/ultralytics), की एक अवलोकन प्रस्तुत करती है।

|

||||

|

||||

1. **YOLOv3:** यह You Only Look Once (YOLO) वस्तु डिटेक्शन एल्गोरिदम का तीसरा संस्करण है। प्रारंभिक रूप में Joseph Redmon ने विकसित किया, YOLOv3 ने योग्यताओं का एक श्रेणी, जैसे कि मल्टीस्केल पूर्वानुमान और तीन भिन्न आकार के डिटेक्शन कर्नल्स, को शामिल करके अपने पूर्वजों पर सुधार किया।

|

||||

|

||||

2. **YOLOv3-Ultralytics:** यह YOLOv3 मॉडल का Ultralytics अनुपालन है। इसने मूल YOLOv3 की वास्तविकता को पुनर्जीवित किया है और अतिरिक्त कार्यक्षमताओं, जैसे कि अधिक पूर्व-प्रशिक्षित मॉडलों का समर्थन और और सुगठनितकरण विकल्पों की सुविधा भी प्रदान करता है।

|

||||

|

||||

3. **YOLOv3u:** यह YOLOv3-Ultralytics का एक अद्यतित संस्करण है जो YOLOv8 मॉडलों में उपयोग में लाया गया एंकर-मुक्त, टैग-न्यूमनेस स्प्लिट हेड को शामिल करता है। YOLOv3u में योग्यता योजना (backbone) और गर्दन (neck) की वास्तविकता तो बनाए रखती है, लेकिन डिटेक्शन हेड को YOLOv8 से अद्यतित कर देती है।

|

||||

|

||||

|

||||

|

||||

## प्रमुख विशेषताएं

|

||||

|

||||

- **YOLOv3:** डिटेक्शन के लिए तीन भिन्न पैमाने का उपयोग करने की एकता वाला यह मॉडल, 13x13, 26x26 और 52x52 के तीन भिन्न आकाृ के डिटेक्शन कर्नल्स के उपयोग से जल्दी जाने जाने वाले वस्तुओं के लिए डिटेक्शन की योग्यता में सुधार करती है। इसके अतिरिक्त, YOLOv3 ने प्रति बाउंडिग बॉक्स के लिए मल्टी-लेबल पूर्वानुमान और एक बेहतर फ़ीचर एक्सट्रैक्टर नेटवर्क जैसी विशेषताएँ भी जोड़ी हैं।

|

||||

|

||||

- **YOLOv3-Ultralytics:** Ultralytics के YOLOv3 के अनुपालन में यह मॉडल मूल मॉडल की प्रदर्शन की समता प्रदान करता है, लेकिन इसके पास अतिरिक्त पूर्व-प्रशिक्षित मॉडलों, अधिक प्रशिक्षण विधियों और सुविधाजनक सुविधाएँ जैसे अतिरिक्त समर्थन होता है। इससे इसका विभिन्न अनुप्रयोगों में उपयोग करना संभव होता है।

|

||||

|

||||

- **YOLOv3u:** यह अद्यतित मॉडल YOLOv8 से योग्यता योजना का उपयोग करता है। योज्ञता के पूर्व-निर्धारित एंकर बॉक्स और पदार्थता स्कोर की आवश्यकता को मिटा कर, यह डिटेक्शन हेड का डिजाइन मॉडल की योग्यता को बेहतरीन आकार और आकृति के वस्तुओं की पहचान करने की क्षमता में सुधार कर सकता है। इससे वस्तु डिटेक्शन के कार्यों के लिए YOLOv3u मॉडलों में बढ़िया सुरक्षा और सटीकता प्राप्त हो सकती है।

|

||||

|

||||

## समर्थित कार्य और मोड

|

||||

|

||||

YOLOv3 श्रृंखला, इनमें YOLOv3, YOLOv3-Ultralytics और YOLOv3u शामिल हैं, विशेष रूप से वस्तु डिटेक्शन कार्यों के लिए विभिन्न प्रतिष्ठित हालत में डिज़ाइन किए गए हैं। ये मॉडल सटीकता और गति में संतुलन स्थापित करने के लिए प्रसिद्ध हैं। प्रत्येक वैरिएंट अद्वितीय सुविधाएँ और अनुकूलन प्रदान करती हैं, इसलिए इनका उपयोग विभिन्न अनुप्रयोगों के लिए संभव है।

|

||||

|

||||

तीनों मॉडलों को पूर्ण उपयोगता में उपयोग करने के लिए विभिन्न मोड हैं, इनमें [इनफेरेंस](../modes/predict.md), [मान्यकरण](../modes/val.md), [प्रशिक्षण](../modes/train.md) और [निर्यात](../modes/export.md) शामिल हैं, विभाजनित किये गए हैं। ये मोडल उपयोगकर्ताओं को वस्तू डिटेक्शन के प्रभावी आवागमन और विकास के विभाजन के विभाजन के लिए एक पूरी उपकरण पर्याप्तता प्रदान करते हैं।

|

||||

|

||||

| मॉडल प्रकार | समर्थित कार्य | इनफेरेंस | मान्यकरण | प्रशिक्षण | निर्यात |

|

||||

|--------------------|--------------------------------------|----------|----------|-----------|---------|

|

||||

| YOLOv3 | [वस्तु डिटेक्शन](../tasks/detect.md) | ✅ | ✅ | ✅ | ✅ |

|

||||

| YOLOv3-Ultralytics | [वस्तु डिटेक्शन](../tasks/detect.md) | ✅ | ✅ | ✅ | ✅ |

|

||||

| YOLOv3u | [वस्तु डिटेक्शन](../tasks/detect.md) | ✅ | ✅ | ✅ | ✅ |

|

||||

|

||||

यह तालिका प्रत्येक YOLOv3 वेरिएंट की क्षमताओं की क्षणभंगुर झलक प्रदान करती है, इसमें विभिन्न कार्यों और ऑपरेशनल मोड के लिए उपयुक्तता और विभाजन मानकों को प्रदर्शित किया गया है।

|

||||

|

||||

## उपयोग की उदाहरण

|

||||

|

||||

यह उदाहरण YOLOv3 प्रशिक्षण और इनफेरेंस के आसान उदाहरण प्रदान करता है। इन और अन्य [मोड](../modes/index.md) के बारे में विस्तारपूर्वक दस्तावेज़ीकरण के लिए इसके साथी [Predict](../modes/predict.md), [Train](../modes/train.md), [Val](../modes/val.md) और [Export](../modes/export.md) दस्तावेज़ पेजेज़ की जांच करें।

|

||||

|

||||

!!! Example "उदाहरण"

|

||||

|

||||

=== "Python"

|

||||

|

||||

`*.pt` प्रीट्रेन किए गए PyTorch मॉडल और कॉन्फ़िगरेशन *.yaml फ़ाइल Python में YOLO() क्लास कों यूज़ करके एक मॉडल इंस्टेंस तैयार करने के लिए पास कर सकते हैं:

|

||||

|

||||

```python

|

||||

from ultralytics import YOLO

|

||||

|

||||

# COCO-pretrained YOLOv3n मॉडल लोड करें

|

||||

model = YOLO('yolov3n.pt')

|

||||

|

||||

# मॉडल की जानकारी प्रदर्शित करें (वैकल्पिक)

|

||||

model.info()

|

||||

|

||||

# COCO8 उदाहरण डेटासेट पर मॉडल 100 epochs के लिए प्रशिक्षण दें

|

||||

results = model.train(data='coco8.yaml', epochs=100, imgsz=640)

|

||||

|

||||

# YOLOv3n मॉडल के साथ 'bus.jpg' छवि पर इनफेरेंस चलाएं

|

||||

results = model('path/to/bus.jpg')

|

||||

```

|

||||

|

||||

=== "CLI"

|

||||

|

||||

मॉडल पर चलाने के लिए CLI आदेश उपलब्ध हैं:

|

||||

|

||||

```bash

|

||||

# COCO-pretrained YOLOv3n मॉडल लोड करें और COCO8 उदाहरण डेटासेट पर इसे 100 epochs के लिए प्रशिक्षित करें

|

||||

yolo train model=yolov3n.pt data=coco8.yaml epochs=100 imgsz=640

|

||||

|

||||

# COCO-pretrained YOLOv3n मॉडल लोड करें और 'bus.jpg' छवि पर इनफेरेंस चलाएं

|

||||

yolo predict model=yolov3n.pt source=path/to/bus.jpg

|

||||

```

|

||||

|

||||

## उद्धरण और प्रशंसापत्र

|

||||

|

||||

अगर आप अपने शोध में YOLOv3 का उपयोग करते हैं, तो कृपया मूल YOLO पेपर्स और Ultralytics YOLOv3 रिपॉज़िटरी को उद्धृत करें।

|

||||

|

||||

!!! उध्दरण ""

|

||||

|

||||

=== "BibTeX"

|

||||

|

||||

```bibtex

|

||||

@article{redmon2018yolov3,

|

||||

title={YOLOv3: An Incremental Improvement},

|

||||

author={Redmon, Joseph and Farhadi, Ali},

|

||||

journal={arXiv preprint arXiv:1804.02767},

|

||||

year={2018}

|

||||

}

|

||||

```

|

||||

|

||||

Joseph Redmon और Ali Farhadi को मूल YOLOv3 विकसकर्ताओं के लिए धन्यवाद।

|

||||

69

docs/hi/models/yolov4.md

Normal file

69

docs/hi/models/yolov4.md

Normal file

|

|

@ -0,0 +1,69 @@

|

|||

---

|

||||

comments: true

|

||||

description: YOLOv4 के बारे में हमारे विस्तृत गाइड पर आपका स्वागत है, जो एक नवीनतम समय मेंकिए गए वास्तविक समय वस्तुओं का पता लगाने वाला उत्कृष्ट ऑब्जेक्ट डिटेक्टर है। इसे योग्यता से उपयोग करने, आर्किटेक्चर के प्रमुख बिंदुओं को समझने और उपयोग की दृष्टि से कुछ उदाहरणों को देखने के लिए पढ़ें।

|

||||

keywords: ultralytics, YOLOv4, ऑब्जेक्ट डिटेक्शन, न्यूरल नेटवर्क, वास्तविक समय में पता लगाने वाला, ऑब्जेक्ट डिटेक्टर, मशीन लर्निंग

|

||||

---

|

||||

|

||||

# YOLOv4: उच्च गति और सटीक ऑब्जेक्ट डिटेक्शन

|

||||

|

||||