Update https://docs.ultralytics.com/models (#6513)

Signed-off-by: Glenn Jocher <glenn.jocher@ultralytics.com> Co-authored-by: pre-commit-ci[bot] <66853113+pre-commit-ci[bot]@users.noreply.github.com>

This commit is contained in:

parent

0c4e97443b

commit

16a13a1ce0

178 changed files with 14224 additions and 561 deletions

193

docs/fr/models/fast-sam.md

Normal file

193

docs/fr/models/fast-sam.md

Normal file

|

|

@ -0,0 +1,193 @@

|

|||

---

|

||||

comments: true

|

||||

description: Découvrez FastSAM, une solution basée sur les réseaux de neurones à convolution (CNN) pour la segmentation d'objets en temps réel dans les images. Interaction utilisateur améliorée, efficacité computationnelle et adaptabilité à différentes tâches de vision.

|

||||

keywords: FastSAM, apprentissage automatique, solution basée sur les CNN, segmentation d'objets, solution en temps réel, Ultralytics, tâches de vision, traitement d'images, applications industrielles, interaction utilisateur

|

||||

---

|

||||

|

||||

# Fast Segment Anything Model (FastSAM)

|

||||

|

||||

Le Fast Segment Anything Model (FastSAM) est une solution basée sur les réseaux de neurones à convolution (CNN) en temps réel pour la tâche Segment Anything. Cette tâche est conçue pour segmenter n'importe quel objet dans une image en fonction de différentes interactions utilisateur possibles. FastSAM réduit considérablement les demandes computationnelles tout en maintenant des performances compétitives, ce qui en fait un choix pratique pour diverses tâches de vision.

|

||||

|

||||

|

||||

|

||||

## Vue d'ensemble

|

||||

|

||||

FastSAM est conçu pour remédier aux limitations du [Segment Anything Model (SAM)](sam.md), un modèle Transformer lourd nécessitant des ressources computationnelles importantes. FastSAM découpe la tâche de segmentation en deux étapes séquentielles : la segmentation de toutes les instances et la sélection guidée par une invitation. La première étape utilise [YOLOv8-seg](../tasks/segment.md) pour produire les masques de segmentation de toutes les instances de l'image. Dans la deuxième étape, il génère la région d'intérêt correspondant à l'invitation.

|

||||

|

||||

## Fonctionnalités clés

|

||||

|

||||

1. **Solution en temps réel :** En exploitant l'efficacité computationnelle des CNN, FastSAM fournit une solution en temps réel pour la tâche Segment Anything, ce qui en fait une solution précieuse pour les applications industrielles nécessitant des résultats rapides.

|

||||

|

||||

2. **Efficacité et performances :** FastSAM offre une réduction significative des demandes computationnelles et des ressources sans compromettre la qualité des performances. Il atteint des performances comparables à SAM, mais avec une réduction drastique des ressources computationnelles, ce qui permet une application en temps réel.

|

||||

|

||||

3. **Segmentation guidée par une invitation :** FastSAM peut segmenter n'importe quel objet dans une image, guidé par différentes invitations d'interaction utilisateur possibles, offrant ainsi flexibilité et adaptabilité dans différents scénarios.

|

||||

|

||||

4. **Basé sur YOLOv8-seg :** FastSAM est basé sur [YOLOv8-seg](../tasks/segment.md), un détecteur d'objets équipé d'une branche de segmentation d'instances. Cela lui permet de produire efficacement les masques de segmentation de toutes les instances dans une image.

|

||||

|

||||

5. **Résultats concurrentiels sur les bancs d'essai :** Dans la tâche de proposition d'objets sur MS COCO, FastSAM obtient des scores élevés à une vitesse significativement plus rapide que [SAM](sam.md) sur une seule NVIDIA RTX 3090, démontrant ainsi son efficacité et sa capacité.

|

||||

|

||||

6. **Applications pratiques :** Cette approche propose une nouvelle solution pratique pour un grand nombre de tâches de vision à une vitesse très élevée, des dizaines ou des centaines de fois plus rapide que les méthodes actuelles.

|

||||

|

||||

7. **Faisabilité de la compression du modèle :** FastSAM démontre la faisabilité d'une voie qui peut réduire considérablement l'effort computationnel en introduisant une contrainte artificielle dans la structure, ouvrant ainsi de nouvelles possibilités pour l'architecture de modèles de grande taille pour les tâches de vision générales.

|

||||

|

||||

## Modèles disponibles, tâches prises en charge et modes d'exploitation

|

||||

|

||||

Ce tableau présente les modèles disponibles avec leurs poids pré-entraînés spécifiques, les tâches qu'ils prennent en charge et leur compatibilité avec différents modes d'exploitation tels que [Inférence](../modes/predict.md), [Validation](../modes/val.md), [Entraînement](../modes/train.md) et [Exportation](../modes/export.md), indiqués par des emojis ✅ pour les modes pris en charge et des emojis ❌ pour les modes non pris en charge.

|

||||

|

||||

| Type de modèle | Poids pré-entraînés | Tâches prises en charge | Inférence | Validation | Entraînement | Exportation |

|

||||

|----------------|---------------------|-------------------------------------------------|-----------|------------|--------------|-------------|

|

||||

| FastSAM-s | `FastSAM-s.pt` | [Segmentation d'instances](../tasks/segment.md) | ✅ | ❌ | ❌ | ✅ |

|

||||

| FastSAM-x | `FastSAM-x.pt` | [Segmentation d'instances](../tasks/segment.md) | ✅ | ❌ | ❌ | ✅ |

|

||||

|

||||

## Exemples d'utilisation

|

||||

|

||||

Les modèles FastSAM sont faciles à intégrer dans vos applications Python. Ultralytics propose une API Python conviviale et des commandes CLI pour simplifier le développement.

|

||||

|

||||

### Utilisation de la prédiction

|

||||

|

||||

Pour effectuer une détection d'objets sur une image, utilisez la méthode `Predict` comme indiqué ci-dessous :

|

||||

|

||||

!!! Example "Exemple"

|

||||

|

||||

=== "Python"

|

||||

```python

|

||||

from ultralytics import FastSAM

|

||||

from ultralytics.models.fastsam import FastSAMPrompt

|

||||

|

||||

# Définir une source d'inférence

|

||||

source = 'chemin/vers/bus.jpg'

|

||||

|

||||

# Créer un modèle FastSAM

|

||||

model = FastSAM('FastSAM-s.pt') # ou FastSAM-x.pt

|

||||

|

||||

# Effectuer une inférence sur une image

|

||||

everything_results = model(source, device='cpu', retina_masks=True, imgsz=1024, conf=0.4, iou=0.9)

|

||||

|

||||

# Préparer un objet Processus Invitation

|

||||

prompt_process = FastSAMPrompt(source, everything_results, device='cpu')

|

||||

|

||||

# Invitation Everything

|

||||

ann = prompt_process.everything_prompt()

|

||||

|

||||

# Bbox shape par défaut [0,0,0,0] -> [x1,y1,x2,y2]

|

||||

ann = prompt_process.box_prompt(bbox=[200, 200, 300, 300])

|

||||

|

||||

# Invitation Text

|

||||

ann = prompt_process.text_prompt(text='une photo d\'un chien')

|

||||

|

||||

# Invitation Point

|

||||

# points par défaut [[0,0]] [[x1,y1],[x2,y2]]

|

||||

# point_label par défaut [0] [1,0] 0:fond, 1:premier plan

|

||||

ann = prompt_process.point_prompt(points=[[200, 200]], pointlabel=[1])

|

||||

prompt_process.plot(annotations=ann, output='./')

|

||||

```

|

||||

|

||||

=== "CLI"

|

||||

```bash

|

||||

# Charger un modèle FastSAM et segmenter tout avec

|

||||

yolo segment predict model=FastSAM-s.pt source=chemin/vers/bus.jpg imgsz=640

|

||||

```

|

||||

|

||||

Cet exemple démontre la simplicité du chargement d'un modèle pré-entraîné et de l'exécution d'une prédiction sur une image.

|

||||

|

||||

### Utilisation de la validation

|

||||

|

||||

La validation du modèle sur un ensemble de données peut être effectuée de la manière suivante :

|

||||

|

||||

!!! Example "Exemple"

|

||||

|

||||

=== "Python"

|

||||

```python

|

||||

from ultralytics import FastSAM

|

||||

|

||||

# Créer un modèle FastSAM

|

||||

model = FastSAM('FastSAM-s.pt') # ou FastSAM-x.pt

|

||||

|

||||

# Valider le modèle

|

||||

results = model.val(data='coco8-seg.yaml')

|

||||

```

|

||||

|

||||

=== "CLI"

|

||||

```bash

|

||||

# Charger un modèle FastSAM et le valider sur l'ensemble de données d'exemple COCO8 avec une taille d'image de 640 pixels

|

||||

yolo segment val model=FastSAM-s.pt data=coco8.yaml imgsz=640

|

||||

```

|

||||

|

||||

Veuillez noter que FastSAM ne prend en charge que la détection et la segmentation d'une seule classe d'objet. Cela signifie qu'il reconnaîtra et segmentera tous les objets comme étant de la même classe. Par conséquent, lors de la préparation de l'ensemble de données, vous devez convertir tous les identifiants de catégorie d'objet en 0.

|

||||

|

||||

## Utilisation officielle de FastSAM

|

||||

|

||||

FastSAM est également disponible directement à partir du dépôt [https://github.com/CASIA-IVA-Lab/FastSAM](https://github.com/CASIA-IVA-Lab/FastSAM). Voici un bref aperçu des étapes typiques que vous pourriez suivre pour utiliser FastSAM :

|

||||

|

||||

### Installation

|

||||

|

||||

1. Clonez le dépôt FastSAM :

|

||||

```shell

|

||||

git clone https://github.com/CASIA-IVA-Lab/FastSAM.git

|

||||

```

|

||||

|

||||

2. Créez et activez un environnement Conda avec Python 3.9 :

|

||||

```shell

|

||||

conda create -n FastSAM python=3.9

|

||||

conda activate FastSAM

|

||||

```

|

||||

|

||||

3. Accédez au dépôt cloné et installez les packages requis :

|

||||

```shell

|

||||

cd FastSAM

|

||||

pip install -r requirements.txt

|

||||

```

|

||||

|

||||

4. Installez le modèle CLIP :

|

||||

```shell

|

||||

pip install git+https://github.com/openai/CLIP.git

|

||||

```

|

||||

|

||||

### Exemple d'utilisation

|

||||

|

||||

1. Téléchargez un [point de contrôle de modèle](https://drive.google.com/file/d/1m1sjY4ihXBU1fZXdQ-Xdj-mDltW-2Rqv/view?usp=sharing).

|

||||

|

||||

2. Utilisez FastSAM pour l'inférence. Exemples de commandes :

|

||||

|

||||

- Segmentez tout dans une image :

|

||||

```shell

|

||||

python Inference.py --model_path ./weights/FastSAM.pt --img_path ./images/dogs.jpg

|

||||

```

|

||||

|

||||

- Segmentez des objets spécifiques à l'aide de l'invitation de texte :

|

||||

```shell

|

||||

python Inference.py --model_path ./weights/FastSAM.pt --img_path ./images/dogs.jpg --text_prompt "le chien jaune"

|

||||

```

|

||||

|

||||

- Segmentez des objets dans un rectangle englobant (fournir les coordonnées du rectangle au format xywh) :

|

||||

```shell

|

||||

python Inference.py --model_path ./weights/FastSAM.pt --img_path ./images/dogs.jpg --box_prompt "[570,200,230,400]"

|

||||

```

|

||||

|

||||

- Segmentez des objets à proximité de points spécifiques :

|

||||

```shell

|

||||

python Inference.py --model_path ./weights/FastSAM.pt --img_path ./images/dogs.jpg --point_prompt "[[520,360],[620,300]]" --point_label "[1,0]"

|

||||

```

|

||||

|

||||

De plus, vous pouvez essayer FastSAM via une [démonstration Colab](https://colab.research.google.com/drive/1oX14f6IneGGw612WgVlAiy91UHwFAvr9?usp=sharing) ou sur la [démonstration Web HuggingFace](https://huggingface.co/spaces/An-619/FastSAM) pour une expérience visuelle.

|

||||

|

||||

## Citations et remerciements

|

||||

|

||||

Nous tenons à remercier les auteurs de FastSAM pour leurs contributions importantes dans le domaine de la segmentation d'instances en temps réel :

|

||||

|

||||

!!! Quote ""

|

||||

|

||||

=== "BibTeX"

|

||||

|

||||

```bibtex

|

||||

@misc{zhao2023fast,

|

||||

title={Fast Segment Anything},

|

||||

author={Xu Zhao and Wenchao Ding and Yongqi An and Yinglong Du and Tao Yu and Min Li and Ming Tang and Jinqiao Wang},

|

||||

year={2023},

|

||||

eprint={2306.12156},

|

||||

archivePrefix={arXiv},

|

||||

primaryClass={cs.CV}

|

||||

}

|

||||

```

|

||||

|

||||

Le document original FastSAM peut être consulté sur [arXiv](https://arxiv.org/abs/2306.12156). Les auteurs ont rendu leur travail accessible au public, et le code source peut être consulté sur [GitHub](https://github.com/CASIA-IVA-Lab/FastSAM). Nous apprécions leurs efforts pour faire avancer le domaine et rendre leur travail accessible à la communauté dans son ensemble.

|

||||

|

|

@ -1,32 +1,32 @@

|

|||

---

|

||||

comments: true

|

||||

description: Explorez la diversité des modèles YOLO, SAM, MobileSAM, FastSAM, YOLO-NAS et RT-DETR pris en charge par Ultralytics. Commencez avec des exemples d'utilisation pour CLI et Python.

|

||||

description: Explorez la gamme diversifiée de modèles de la famille YOLO, SAM, MobileSAM, FastSAM, YOLO-NAS et RT-DETR pris en charge par Ultralytics. Commencez avec des exemples pour l'utilisation CLI et Python.

|

||||

keywords: Ultralytics, documentation, YOLO, SAM, MobileSAM, FastSAM, YOLO-NAS, RT-DETR, modèles, architectures, Python, CLI

|

||||

---

|

||||

|

||||

# Modèles pris en charge par Ultralytics

|

||||

|

||||

Bienvenue dans la documentation des modèles d'Ultralytics ! Nous proposons une prise en charge d'une large gamme de modèles, chacun adapté à des tâches spécifiques comme [la détection d'objets](../tasks/detect.md), [la segmentation d'instances](../tasks/segment.md), [la classification d'images](../tasks/classify.md), [l'estimation de posture](../tasks/pose.md) et [le suivi multi-objets](../modes/track.md). Si vous souhaitez contribuer avec votre architecture de modèle à Ultralytics, consultez notre [Guide de Contribution](../../help/contributing.md).

|

||||

Bienvenue dans la documentation des modèles d'Ultralytics ! Nous offrons un soutien pour une large gamme de modèles, chacun étant adapté à des tâches spécifiques comme [la détection d'objets](../tasks/detect.md), [la segmentation d'instance](../tasks/segment.md), [la classification d'images](../tasks/classify.md), [l'estimation de pose](../tasks/pose.md), et [le suivi multi-objets](../modes/track.md). Si vous êtes intéressé à contribuer avec votre architecture de modèle à Ultralytics, consultez notre [Guide de Contribution](../../help/contributing.md).

|

||||

|

||||

!!! Note "Note"

|

||||

!!! Note "Remarque"

|

||||

|

||||

🚧 Notre documentation multilingue est actuellement en construction et nous travaillons activement à l'améliorer. Merci de votre patience ! 🙏

|

||||

🚧 Notre documentation dans différentes langues est actuellement en construction, et nous travaillons dur pour l'améliorer. Merci de votre patience ! 🙏

|

||||

|

||||

## Modèles en vedette

|

||||

|

||||

Voici quelques-uns des modèles clés pris en charge :

|

||||

|

||||

1. **[YOLOv3](../../models/yolov3.md)** : La troisième itération de la famille de modèles YOLO, originellement par Joseph Redmon, reconnue pour ses capacités de détection d'objets en temps réel efficaces.

|

||||

2. **[YOLOv4](../../models/yolov4.md)** : Une mise à jour de YOLOv3 native de darknet, publiée par Alexey Bochkovskiy en 2020.

|

||||

3. **[YOLOv5](../../models/yolov5.md)** : Une version améliorée de l'architecture YOLO par Ultralytics, offrant de meilleurs compromis de performance et de vitesse par rapport aux versions précédentes.

|

||||

4. **[YOLOv6](../../models/yolov6.md)** : Publié par [Meituan](https://about.meituan.com/) en 2022, et utilisé dans de nombreux robots de livraison autonomes de l'entreprise.

|

||||

5. **[YOLOv7](../../models/yolov7.md)** : Modèles YOLO mis à jour et sortis en 2022 par les auteurs de YOLOv4.

|

||||

6. **[YOLOv8](../../models/yolov8.md)** : La dernière version de la famille YOLO, avec des capacités améliorées telles que la segmentation d’instances, l'estimation de pose/points clés, et la classification.

|

||||

7. **[Segment Anything Model (SAM)](../../models/sam.md)** : Le modèle Segment Anything Model (SAM) de Meta.

|

||||

8. **[Mobile Segment Anything Model (MobileSAM)](../../models/mobile-sam.md)** : MobileSAM pour les applications mobiles, par l'Université de Kyung Hee.

|

||||

9. **[Fast Segment Anything Model (FastSAM)](../../models/fast-sam.md)** : FastSAM par le groupe d’Analyse Image et Vidéo, Institut d'Automatisation, Académie Chinoise des Sciences.

|

||||

10. **[YOLO-NAS](../../models/yolo-nas.md)** : Modèles YOLO Neural Architecture Search (NAS).

|

||||

11. **[Realtime Detection Transformers (RT-DETR)](../../models/rtdetr.md)** : Modèles de Realtime Detection Transformer (RT-DETR) de Baidu's PaddlePaddle.

|

||||

1. **[YOLOv3](yolov3.md)** : La troisième itération de la famille de modèles YOLO, initialement par Joseph Redmon, connue pour ses capacités de détection d'objets en temps réel efficaces.

|

||||

2. **[YOLOv4](yolov4.md)** : Une mise à jour native darknet de YOLOv3, publiée par Alexey Bochkovskiy en 2020.

|

||||

3. **[YOLOv5](yolov5.md)** : Une version améliorée de l'architecture YOLO par Ultralytics, offrant de meilleures performances et compromis de vitesse par rapport aux versions précédentes.

|

||||

4. **[YOLOv6](yolov6.md)** : Publié par [Meituan](https://about.meituan.com/) en 2022, et utilisé dans beaucoup de ses robots de livraison autonomes.

|

||||

5. **[YOLOv7](yolov7.md)** : Modèles YOLO mis à jour publiés en 2022 par les auteurs de YOLOv4.

|

||||

6. **[YOLOv8](yolov8.md) NOUVEAU 🚀**: La dernière version de la famille YOLO, présentant des capacités améliorées telles que la segmentation d'instance, l'estimation de pose/points clés et la classification.

|

||||

7. **[Segment Anything Model (SAM)](sam.md)** : Le modèle Segment Anything Model (SAM) de Meta.

|

||||

8. **[Mobile Segment Anything Model (MobileSAM)](mobile-sam.md)** : MobileSAM pour applications mobiles, développé par l'Université de Kyung Hee.

|

||||

9. **[Fast Segment Anything Model (FastSAM)](fast-sam.md)** : FastSAM par le Image & Video Analysis Group, Institute of Automation, Chinese Academy of Sciences.

|

||||

10. **[YOLO-NAS](yolo-nas.md)** : Modèles de Recherche d'Architecture Neuronale YOLO (NAS).

|

||||

11. **[Realtime Detection Transformers (RT-DETR)](rtdetr.md)** : Modèles du Transformateur de Détection en Temps Réel (RT-DETR) de PaddlePaddle de Baidu.

|

||||

|

||||

<p align="center">

|

||||

<br>

|

||||

|

|

@ -39,24 +39,28 @@ Voici quelques-uns des modèles clés pris en charge :

|

|||

<strong>Regardez :</strong> Exécutez les modèles YOLO d'Ultralytics en seulement quelques lignes de code.

|

||||

</p>

|

||||

|

||||

## Pour commencer : Exemples d'utilisation

|

||||

## Pour Commencer : Exemples d'Utilisation

|

||||

|

||||

Cet exemple fournit des exemples simples d'entraînement et d'inférence YOLO. Pour une documentation complète sur ces [modes](../modes/index.md) et d'autres, consultez les pages de documentation [Prédire](../modes/predict.md), [Entraîner](../modes/train.md), [Val](../modes/val.md) et [Exporter](../modes/export.md).

|

||||

|

||||

Notez que l'exemple ci-dessous concerne les modèles [Detect](../tasks/detect.md) YOLOv8 pour la détection d'objets. Pour des tâches supplémentaires prises en charge, voir les documentations [Segmenter](../tasks/segment.md), [Classifier](../tasks/classify.md) et [Poser](../tasks/pose.md).

|

||||

|

||||

!!! Example "Exemple"

|

||||

|

||||

=== "Python"

|

||||

|

||||

Les modèles préentrainés `*.pt` ainsi que les fichiers de configuration `*.yaml` peuvent être passés aux classes `YOLO()`, `SAM()`, `NAS()` et `RTDETR()` pour créer une instance du modèle en Python :

|

||||

Des modèles pré-entraînés PyTorch `*.pt` ainsi que des fichiers de configuration `*.yaml` peuvent être passés aux classes `YOLO()`, `SAM()`, `NAS()` et `RTDETR()` pour créer une instance de modèle en Python :

|

||||

|

||||

```python

|

||||

from ultralytics import YOLO

|

||||

|

||||

# Charger un modèle YOLOv8n préentrainé sur COCO

|

||||

# Charger un modèle YOLOv8n pré-entraîné sur COCO

|

||||

model = YOLO('yolov8n.pt')

|

||||

|

||||

# Afficher les informations du modèle (optionnel)

|

||||

model.info()

|

||||

|

||||

# Entraîner le modèle sur l'exemple de jeu de données COCO8 pendant 100 époques

|

||||

# Entraîner le modèle sur le jeu de données exemple COCO8 pendant 100 époques

|

||||

results = model.train(data='coco8.yaml', epochs=100, imgsz=640)

|

||||

|

||||

# Exécuter l'inférence avec le modèle YOLOv8n sur l'image 'bus.jpg'

|

||||

|

|

@ -68,27 +72,27 @@ Voici quelques-uns des modèles clés pris en charge :

|

|||

Des commandes CLI sont disponibles pour exécuter directement les modèles :

|

||||

|

||||

```bash

|

||||

# Charger un modèle YOLOv8n préentrainé sur COCO et l'entraîner sur l'exemple de jeu de données COCO8 pendant 100 époques

|

||||

# Charger un modèle YOLOv8n pré-entraîné sur COCO et l'entraîner sur le jeu de données exemple COCO8 pendant 100 époques

|

||||

yolo train model=yolov8n.pt data=coco8.yaml epochs=100 imgsz=640

|

||||

|

||||

# Charger un modèle YOLOv8n préentrainé sur COCO et exécuter l'inférence sur l'image 'bus.jpg'

|

||||

# Charger un modèle YOLOv8n pré-entraîné sur COCO et exécuter l'inférence sur l'image 'bus.jpg'

|

||||

yolo predict model=yolov8n.pt source=path/to/bus.jpg

|

||||

```

|

||||

|

||||

## Contribuer de nouveaux modèles

|

||||

## Contribution de Nouveaux Modèles

|

||||

|

||||

Intéressé à contribuer votre modèle à Ultralytics ? Super ! Nous sommes toujours ouverts à l'expansion de notre portefeuille de modèles.

|

||||

Vous êtes intéressé à contribuer votre modèle à Ultralytics ? Génial ! Nous sommes toujours ouverts à l'expansion de notre portefeuille de modèles.

|

||||

|

||||

1. **Forker le Répertoire** : Commencez par forker le [répertoire GitHub d'Ultralytics](https://github.com/ultralytics/ultralytics).

|

||||

1. **Forkez le Référentiel** : Commencez par forker le [référentiel GitHub d'Ultralytics](https://github.com/ultralytics/ultralytics).

|

||||

|

||||

2. **Cloner Votre Fork** : Clonez votre fork sur votre machine locale et créez une nouvelle branche pour travailler dessus.

|

||||

2. **Clonez Votre Fork** : Clonez votre fork sur votre machine locale et créez une nouvelle branche pour travailler dessus.

|

||||

|

||||

3. **Implémenter Votre Modèle** : Ajoutez votre modèle en suivant les standards et directives de codage fournis dans notre [Guide de Contribution](../../help/contributing.md).

|

||||

3. **Implémentez Votre Modèle** : Ajoutez votre modèle en suivant les normes et directives de codage fournies dans notre [Guide de Contribution](../../help/contributing.md).

|

||||

|

||||

4. **Tester Rigoureusement** : Assurez-vous de tester votre modèle de manière rigoureuse, à la fois isolément et en tant que partie du pipeline.

|

||||

4. **Testez Rigoureusement** : Assurez-vous de tester votre modèle de manière rigoureuse, à la fois isolément et comme partie du pipeline.

|

||||

|

||||

5. **Créer une Pull Request** : Une fois que vous êtes satisfait de votre modèle, créez une demandе de tirage (pull request) vers le répertoire principal pour examen.

|

||||

5. **Créez une Pull Request** : Une fois que vous êtes satisfait de votre modèle, créez une pull request au répertoire principal pour examen.

|

||||

|

||||

6. **Revue de Code & Fusion** : Après la revue, si votre modèle répond à nos critères, il sera fusionné dans le répertoire principal.

|

||||

6. **Revue de Code & Fusion** : Après examen, si votre modèle répond à nos critères, il sera fusionné dans le répertoire principal.

|

||||

|

||||

Pour des étapes détaillées, consultez notre [Guide de Contribution](../../help/contributing.md).

|

||||

|

|

|

|||

116

docs/fr/models/mobile-sam.md

Normal file

116

docs/fr/models/mobile-sam.md

Normal file

|

|

@ -0,0 +1,116 @@

|

|||

---

|

||||

comments: true

|

||||

description: En savoir plus sur MobileSAM, son implémentation, la comparaison avec SAM d'origine, et comment le télécharger et le tester dans le cadre de l'environnement Ultralytics. Améliorez vos applications mobiles dès aujourd'hui.

|

||||

keywords: MobileSAM, Ultralytics, SAM, applications mobiles, Arxiv, GPU, API, encodeur d'image, décodeur de masque, téléchargement de modèle, méthode de test

|

||||

---

|

||||

|

||||

|

||||

|

||||

# Segmenter N'importe Quoi sur Mobile (MobileSAM)

|

||||

|

||||

Le document MobileSAM est maintenant disponible sur [arXiv](https://arxiv.org/pdf/2306.14289.pdf).

|

||||

|

||||

Une démonstration de MobileSAM exécutée sur un processeur CPU est accessible via ce [lien de démonstration](https://huggingface.co/spaces/dhkim2810/MobileSAM). Les performances sur un CPU Mac i5 prennent environ 3 secondes. Sur la démo de Hugging Face, l'interface ainsi que les CPU moins performants contribuent à une réponse plus lente, mais cela continue de fonctionner efficacement.

|

||||

|

||||

MobileSAM est implémenté dans divers projets, notamment [Grounding-SAM](https://github.com/IDEA-Research/Grounded-Segment-Anything), [AnyLabeling](https://github.com/vietanhdev/anylabeling), et [Segment Anything en 3D](https://github.com/Jumpat/SegmentAnythingin3D).

|

||||

|

||||

MobileSAM est entraîné sur un seul GPU avec un ensemble de données de 100 000 images (1% des images originales) en moins d'une journée. Le code de cet entraînement sera disponible à l'avenir.

|

||||

|

||||

## Modèles Disponibles, Tâches Prises en Charge et Modes d'Utilisation

|

||||

|

||||

Ce tableau présente les modèles disponibles avec leurs poids pré-entraînés spécifiques, les tâches qu'ils prennent en charge, et leur compatibilité avec les différents modes d'utilisation tels que [Inférence](../modes/predict.md), [Validation](../modes/val.md), [Entraînement](../modes/train.md) et [Export](../modes/export.md), indiqués par les emojis ✅ pour les modes pris en charge et ❌ pour les modes non pris en charge.

|

||||

|

||||

| Type de Modèle | Poids Pré-entraînés | Tâches Prises en Charge | Inférence | Validation | Entraînement | Export |

|

||||

|----------------|---------------------|-------------------------------------------------|-----------|------------|--------------|--------|

|

||||

| MobileSAM | `mobile_sam.pt` | [Segmentation d'Instances](../tasks/segment.md) | ✅ | ❌ | ❌ | ✅ |

|

||||

|

||||

## Passage de SAM à MobileSAM

|

||||

|

||||

Étant donné que MobileSAM conserve le même pipeline que SAM d'origine, nous avons incorporé le pré-traitement, le post-traitement et toutes les autres interfaces de l'original. Par conséquent, ceux qui utilisent actuellement SAM d'origine peuvent passer à MobileSAM avec un effort minimal.

|

||||

|

||||

MobileSAM a des performances comparables à celles de SAM d'origine et conserve le même pipeline à l'exception d'un changement dans l'encodeur d'image. Plus précisément, nous remplaçons l'encodeur d'image lourd original ViT-H (632M) par un encodeur Tiny-ViT plus petit (5M). Sur un seul GPU, MobileSAM fonctionne à environ 12 ms par image : 8 ms sur l'encodeur d'image et 4 ms sur le décodeur de masque.

|

||||

|

||||

Le tableau suivant présente une comparaison des encodeurs d'image basés sur ViT :

|

||||

|

||||

| Encodeur d'Image | SAM d'Origine | MobileSAM |

|

||||

|------------------|---------------|-----------|

|

||||

| Paramètres | 611M | 5M |

|

||||

| Vitesse | 452 ms | 8 ms |

|

||||

|

||||

SAM d'origine et MobileSAM utilisent tous deux le même décodeur de masque basé sur une instruction :

|

||||

|

||||

| Décodeur de Masque | SAM d'Origine | MobileSAM |

|

||||

|--------------------|---------------|-----------|

|

||||

| Paramètres | 3.876M | 3.876M |

|

||||

| Vitesse | 4 ms | 4 ms |

|

||||

|

||||

Voici une comparaison du pipeline complet :

|

||||

|

||||

| Pipeline Complet (Enc+Dec) | SAM d'Origine | MobileSAM |

|

||||

|----------------------------|---------------|-----------|

|

||||

| Paramètres | 615M | 9.66M |

|

||||

| Vitesse | 456 ms | 12 ms |

|

||||

|

||||

Les performances de MobileSAM et de SAM d'origine sont démontrées en utilisant à la fois un point et une boîte comme instructions.

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

Avec ses performances supérieures, MobileSAM est environ 5 fois plus petit et 7 fois plus rapide que FastSAM actuel. Plus de détails sont disponibles sur la [page du projet MobileSAM](https://github.com/ChaoningZhang/MobileSAM).

|

||||

|

||||

## Test de MobileSAM dans Ultralytics

|

||||

|

||||

Tout comme SAM d'origine, nous proposons une méthode de test simple dans Ultralytics, comprenant des modes pour les instructions Point et Boîte.

|

||||

|

||||

### Téléchargement du modèle

|

||||

|

||||

Vous pouvez télécharger le modèle [ici](https://github.com/ChaoningZhang/MobileSAM/blob/master/weights/mobile_sam.pt).

|

||||

|

||||

### Instruction Point

|

||||

|

||||

!!! Example "Exemple"

|

||||

|

||||

=== "Python"

|

||||

```python

|

||||

from ultralytics import SAM

|

||||

|

||||

# Chargement du modèle

|

||||

model = SAM('mobile_sam.pt')

|

||||

|

||||

# Prédiction d'un segment à partir d'une instruction Point

|

||||

model.predict('ultralytics/assets/zidane.jpg', points=[900, 370], labels=[1])

|

||||

```

|

||||

|

||||

### Instruction Boîte

|

||||

|

||||

!!! Example "Exemple"

|

||||

|

||||

=== "Python"

|

||||

```python

|

||||

from ultralytics import SAM

|

||||

|

||||

# Chargement du modèle

|

||||

model = SAM('mobile_sam.pt')

|

||||

|

||||

# Prédiction d'un segment à partir d'une instruction Boîte

|

||||

model.predict('ultralytics/assets/zidane.jpg', bboxes=[439, 437, 524, 709])

|

||||

```

|

||||

|

||||

Nous avons mis en œuvre `MobileSAM` et `SAM` en utilisant la même API. Pour plus d'informations sur l'utilisation, veuillez consulter la [page SAM](sam.md).

|

||||

|

||||

## Citations et Remerciements

|

||||

|

||||

Si vous trouvez MobileSAM utile dans vos travaux de recherche ou de développement, veuillez envisager de citer notre document :

|

||||

|

||||

!!! Quote ""

|

||||

|

||||

=== "BibTeX"

|

||||

|

||||

```bibtex

|

||||

@article{mobile_sam,

|

||||

title={Faster Segment Anything: Towards Lightweight SAM for Mobile Applications},

|

||||

author={Zhang, Chaoning and Han, Dongshen and Qiao, Yu and Kim, Jung Uk and Bae, Sung Ho and Lee, Seungkyu and Hong, Choong Seon},

|

||||

journal={arXiv preprint arXiv:2306.14289},

|

||||

year={2023}

|

||||

}

|

||||

93

docs/fr/models/rtdetr.md

Normal file

93

docs/fr/models/rtdetr.md

Normal file

|

|

@ -0,0 +1,93 @@

|

|||

---

|

||||

comments: true

|

||||

description: Découvrez les fonctionnalités et les avantages de RT-DETR de Baidu, un détecteur d'objets en temps réel efficace et adaptable grâce aux Vision Transformers, incluant des modèles pré-entraînés.

|

||||

keywords: RT-DETR, Baidu, Vision Transformers, détection d'objets, performance en temps réel, CUDA, TensorRT, sélection de requêtes informée par IoU, Ultralytics, API Python, PaddlePaddle

|

||||

---

|

||||

|

||||

# RT-DETR de Baidu : un détecteur d'objets en temps réel basé sur les Vision Transformers

|

||||

|

||||

## Présentation

|

||||

|

||||

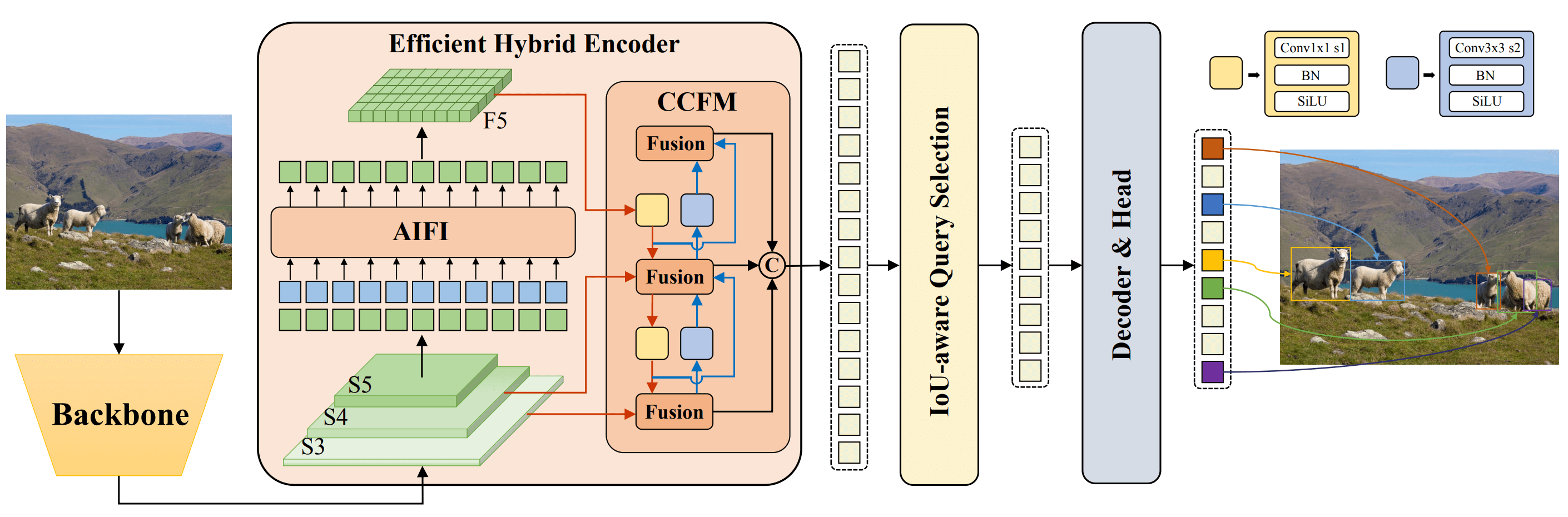

Le Real-Time Detection Transformer (RT-DETR), développé par Baidu, est un détecteur d'objets de pointe de bout en bout qui offre des performances en temps réel tout en maintenant une grande précision. Il exploite la puissance des Vision Transformers (ViT) pour traiter efficacement les caractéristiques multiscalaires en dissociant l'interaction intra-échelle et la fusion inter-échelles. RT-DETR est hautement adaptable, permettant un ajustement flexible de la vitesse d'inférence en utilisant différentes couches de décodeur sans nécessiter de nouvelle formation. Le modèle est performant sur des infrastructures accélérées telles que CUDA avec TensorRT, surpassant de nombreux autres détecteurs d'objets en temps réel.

|

||||

|

||||

|

||||

**Vue d'ensemble du RT-DETR de Baidu.** Le diagramme d'architecture du modèle RT-DETR montre les trois dernières étapes du réseau {S3, S4, S5} comme entrée de l'encodeur. L'encodeur hybride efficace transforme les caractéristiques multiscalaires en une séquence de caractéristiques d'image grâce à l'interaction à l'intérieur de l'échelle (AIFI - *Adeptation of Intra-scale Feature Interaction*) et au module de fusion inter-échelles (CCFM - *Cross-scale Context-aware Feature Fusion Module*). La sélection de requêtes informée par IoU est utilisée pour sélectionner un nombre fixe de caractéristiques d'image pour servir de requêtes d'objets initiales pour le décodeur. Enfin, le décodeur avec des têtes de prédictions auxiliaires optimise de manière itérative les requêtes d'objets pour générer des boîtes et des scores de confiance ([source](https://arxiv.org/pdf/2304.08069.pdf)).

|

||||

|

||||

### Fonctionnalités principales

|

||||

|

||||

- **Encodeur hybride efficace :** RT-DETR de Baidu utilise un encodeur hybride efficace qui traite les caractéristiques multiscalaires en dissociant l'interaction intra-échelle et la fusion inter-échelles. Cette conception unique basée sur les Vision Transformers réduit les coûts de calcul et permet une détection d'objets en temps réel.

|

||||

- **Sélection de requêtes informée par IoU :** RT-DETR de Baidu améliore l'initialisation des requêtes d'objets en utilisant une sélection de requêtes informée par IoU. Cela permet au modèle de se concentrer sur les objets les plus pertinents de la scène, améliorant ainsi la précision de la détection.

|

||||

- **Vitesse d'inférence adaptable :** RT-DETR de Baidu prend en charge des ajustements flexibles de la vitesse d'inférence en utilisant différentes couches de décodeur sans nécessiter de nouvelle formation. Cette adaptabilité facilite l'application pratique dans différents scénarios de détection d'objets en temps réel.

|

||||

|

||||

## Modèles pré-entraînés

|

||||

|

||||

L'API Python Ultralytics fournit des modèles pré-entraînés RT-DETR de PaddlePaddle avec différentes échelles :

|

||||

|

||||

- RT-DETR-L : 53,0 % de précision moyenne (AP) sur COCO val2017, 114 images par seconde (FPS) sur GPU T4

|

||||

- RT-DETR-X : 54,8 % de précision moyenne (AP) sur COCO val2017, 74 images par seconde (FPS) sur GPU T4

|

||||

|

||||

## Exemples d'utilisation

|

||||

|

||||

Cet exemple présente des exemples simples d'entraînement et d'inférence avec RT-DETRR. Pour une documentation complète sur ceux-ci et d'autres [modes](../modes/index.md), consultez les pages de documentation [Predict](../modes/predict.md), [Train](../modes/train.md), [Val](../modes/val.md) et [Export](../modes/export.md).

|

||||

|

||||

!!! Example "Exemple"

|

||||

|

||||

=== "Python"

|

||||

|

||||

```python

|

||||

from ultralytics import RTDETR

|

||||

|

||||

# Charger un modèle RT-DETR-l pré-entraîné sur COCO

|

||||

model = RTDETR('rtdetr-l.pt')

|

||||

|

||||

# Afficher des informations sur le modèle (facultatif)

|

||||

model.info()

|

||||

|

||||

# Entraîner le modèle sur l'ensemble de données d'exemple COCO8 pendant 100 époques

|

||||

results = model.train(data='coco8.yaml', epochs=100, imgsz=640)

|

||||

|

||||

# Effectuer une inférence avec le modèle RT-DETR-l sur l'image 'bus.jpg'

|

||||

results = model('path/to/bus.jpg')

|

||||

```

|

||||

|

||||

=== "CLI"

|

||||

|

||||

```bash

|

||||

# Charger un modèle RT-DETR-l pré-entraîné sur COCO et l'entraîner sur l'ensemble de données d'exemple COCO8 pendant 100 époques

|

||||

yolo train model=rtdetr-l.pt data=coco8.yaml epochs=100 imgsz=640

|

||||

|

||||

# Charger un modèle RT-DETR-l pré-entraîné sur COCO et effectuer une inférence sur l'image 'bus.jpg'

|

||||

yolo predict model=rtdetr-l.pt source=path/to/bus.jpg

|

||||

```

|

||||

|

||||

## Tâches et modes pris en charge

|

||||

|

||||

Ce tableau présente les types de modèles, les poids pré-entraînés spécifiques, les tâches prises en charge par chaque modèle et les différents modes ([Train](../modes/train.md), [Val](../modes/val.md), [Predict](../modes/predict.md), [Export](../modes/export.md)) pris en charge, indiqués par des emojis ✅.

|

||||

|

||||

| Type de modèle | Poids pré-entraînés | Tâches prises en charge | Inférence | Validation | Entraînement | Export |

|

||||

|---------------------|---------------------|------------------------------------------|-----------|------------|--------------|--------|

|

||||

| RT-DETR Large | `rtdetr-l.pt` | [Détection d'objets](../tasks/detect.md) | ✅ | ✅ | ✅ | ✅ |

|

||||

| RT-DETR Extra-Large | `rtdetr-x.pt` | [Détection d'objets](../tasks/detect.md) | ✅ | ✅ | ✅ | ✅ |

|

||||

|

||||

## Citations et Remerciements

|

||||

|

||||

Si vous utilisez RT-DETR de Baidu dans votre travail de recherche ou de développement, veuillez citer l'[article original](https://arxiv.org/abs/2304.08069) :

|

||||

|

||||

!!! Quote ""

|

||||

|

||||

=== "BibTeX"

|

||||

|

||||

```bibtex

|

||||

@misc{lv2023detrs,

|

||||

title={DETRs Beat YOLOs on Real-time Object Detection},

|

||||

author={Wenyu Lv and Shangliang Xu and Yian Zhao and Guanzhong Wang and Jinman Wei and Cheng Cui and Yuning Du and Qingqing Dang and Yi Liu},

|

||||

year={2023},

|

||||

eprint={2304.08069},

|

||||

archivePrefix={arXiv},

|

||||

primaryClass={cs.CV}

|

||||

}

|

||||

```

|

||||

|

||||

Nous tenons à remercier Baidu et l'équipe [PaddlePaddle](https://github.com/PaddlePaddle/PaddleDetection) pour la création et la maintenance de cette précieuse ressource pour la communauté de la vision par ordinateur. Leur contribution au domaine avec le développement du détecteur d'objets en temps réel basé sur les Vision Transformers, RT-DETR, est grandement appréciée.

|

||||

|

||||

*keywords: RT-DETR, Transformer, ViT, Vision Transformers, RT-DETR de Baidu, PaddlePaddle, Modèles PaddlePaddle RT-DETR pré-entraînés, utilisation de RT-DETR de Baidu, API Python Ultralytics, détection d'objets en temps réel*

|

||||

226

docs/fr/models/sam.md

Normal file

226

docs/fr/models/sam.md

Normal file

|

|

@ -0,0 +1,226 @@

|

|||

---

|

||||

comments: true

|

||||

description: Découvrez le modèle Segment Anything (SAM) de pointe d'Ultralytics permettant la segmentation d'images en temps réel. Apprenez-en davantage sur sa segmentation promptable, ses performances hors échantillon et comment l'utiliser.

|

||||

keywords: Ultralytics, segmentation d'image, Segment Anything Model, SAM, SA-1B dataset, performances en temps réel, transfert hors échantillon, détection d'objets, analyse d'images, apprentissage automatique

|

||||

---

|

||||

|

||||

# Segment Anything Model (SAM)

|

||||

|

||||

Bienvenue à la pointe de la segmentation d'image avec le modèle Segment Anything, ou SAM. Ce modèle révolutionnaire a changé la donne en introduisant la segmentation d'image promptable avec des performances en temps réel, établissant de nouvelles normes dans le domaine.

|

||||

|

||||

## Introduction à SAM : Le modèle Segment Anything

|

||||

|

||||

Le modèle Segment Anything, ou SAM, est un modèle de segmentation d'image de pointe qui permet une segmentation promptable, offrant une polyvalence inégalée dans les tâches d'analyse d'image. SAM forme le cœur de l'initiative Segment Anything, un projet innovant qui introduit un modèle, une tâche et un jeu de données novateurs pour la segmentation d'images.

|

||||

|

||||

La conception avancée de SAM lui permet de s'adapter à de nouvelles distributions et tâches d'images sans connaissance préalable, une fonctionnalité connue sous le nom de transfert hors échantillon. Entraîné sur le vaste ensemble de données [SA-1B](https://ai.facebook.com/datasets/segment-anything/), qui contient plus d'un milliard de masques répartis sur 11 millions d'images soigneusement sélectionnées, SAM a affiché des performances hors échantillon impressionnantes, dépassant les résultats entièrement supervisés précédents dans de nombreux cas.

|

||||

|

||||

|

||||

Exemple d'images avec des masques superposés provenant de notre nouveau jeu de données, SA-1B. SA-1B contient 11 millions d'images diverses, haute résolution, autorisées et protégeant la vie privée, ainsi que 1,1 milliard de masques de segmentation de haute qualité. Ces masques ont été annotés entièrement automatiquement par SAM, et comme le confirment des évaluations humaines et de nombreux tests, leur qualité et leur diversité sont élevées. Les images sont regroupées par nombre de masques par image pour la visualisation (il y a environ 100 masques par image en moyenne).

|

||||

|

||||

## Caractéristiques clés du modèle Segment Anything (SAM)

|

||||

|

||||

- **Tâche de segmentation promptable :** SAM a été conçu en gardant à l'esprit une tâche de segmentation promptable, ce qui lui permet de générer des masques de segmentation valides à partir de n'importe quelle indication donnée, telle que des indices spatiaux ou des indices textuels identifiant un objet.

|

||||

- **Architecture avancée :** Le modèle Segment Anything utilise un puissant encodeur d'images, un encodeur de prompt et un décodeur de masques léger. Cette architecture unique permet une invitation flexible, un calcul de masques en temps réel et une prise en compte de l'ambiguïté dans les tâches de segmentation.

|

||||

- **Le jeu de données SA-1B :** Introduit par le projet Segment Anything, le jeu de données SA-1B comprend plus d'un milliard de masques sur 11 millions d'images. En tant que plus grand jeu de données de segmentation à ce jour, il offre à SAM une source de données d'entraînement diversifiée et à grande échelle.

|

||||

- **Performances hors échantillon :** SAM affiche des performances hors échantillon exceptionnelles dans diverses tâches de segmentation, ce qui en fait un outil prêt à l'emploi pour des applications diverses nécessitant un minimum d'ingénierie de prompt.

|

||||

|

||||

Pour une analyse approfondie du modèle Segment Anything et du jeu de données SA-1B, veuillez visiter le [site web Segment Anything](https://segment-anything.com) et consulter l'article de recherche [Segment Anything](https://arxiv.org/abs/2304.02643).

|

||||

|

||||

## Modèles disponibles, tâches prises en charge et modes d'exploitation

|

||||

|

||||

Ce tableau présente les modèles disponibles avec leurs poids pré-entraînés spécifiques, les tâches qu'ils prennent en charge et leur compatibilité avec différents modes d'exploitation tels que [Inférence](../modes/predict.md), [Validation](../modes/val.md), [Entraînement](../modes/train.md) et [Exportation](../modes/export.md), indiqués par des emojis ✅ pour les modes pris en charge et des emojis ❌ pour les modes non pris en charge.

|

||||

|

||||

| Type de modèle | Poids pré-entraînés | Tâches prises en charge | Inférence | Validation | Entraînement | Exportation |

|

||||

|----------------|---------------------|------------------------------------------------|-----------|------------|--------------|-------------|

|

||||

| SAM de base | `sam_b.pt` | [Segmentation d'instance](../tasks/segment.md) | ✅ | ❌ | ❌ | ✅ |

|

||||

| SAM large | `sam_l.pt` | [Segmentation d'instance](../tasks/segment.md) | ✅ | ❌ | ❌ | ✅ |

|

||||

|

||||

## Comment utiliser SAM : Polyvalence et puissance dans la segmentation d'images

|

||||

|

||||

Le modèle Segment Anything peut être utilisé pour une multitude de tâches secondaires qui vont au-delà de ses données d'entraînement. Cela comprend la détection des contours, la génération de propositions d'objets, la segmentation d'instances et la prédiction préliminaire texte-à-masque. Grâce à l'ingénierie de prompts, SAM peut s'adapter rapidement à de nouvelles tâches et distributions de données de manière sans apprentissage, ce qui en fait un outil polyvalent et puissant pour tous vos besoins en matière de segmentation d'images.

|

||||

|

||||

### Exemple de prédiction SAM

|

||||

|

||||

!!! Example "Segmentation avec des prompts"

|

||||

|

||||

Segmenter l'image avec des prompts donnés.

|

||||

|

||||

=== "Python"

|

||||

|

||||

```python

|

||||

from ultralytics import SAM

|

||||

|

||||

# Charger un modèle

|

||||

model = SAM('sam_b.pt')

|

||||

|

||||

# Afficher les informations sur le modèle (facultatif)

|

||||

model.info()

|

||||

|

||||

# Exécuter l'inférence avec un prompt de zones de délimitation

|

||||

model('ultralytics/assets/zidane.jpg', bboxes=[439, 437, 524, 709])

|

||||

|

||||

# Exécuter l'inférence avec un prompt de points

|

||||

model('ultralytics/assets/zidane.jpg', points=[900, 370], labels=[1])

|

||||

```

|

||||

|

||||

!!! Example "Segmenter tout"

|

||||

|

||||

Segmenter toute l'image.

|

||||

|

||||

=== "Python"

|

||||

|

||||

```python

|

||||

from ultralytics import SAM

|

||||

|

||||

# Charger un modèle

|

||||

model = SAM('sam_b.pt')

|

||||

|

||||

# Afficher les informations sur le modèle (facultatif)

|

||||

model.info()

|

||||

|

||||

# Exécuter l'inférence

|

||||

model('path/to/image.jpg')

|

||||

```

|

||||

|

||||

=== "CLI"

|

||||

|

||||

```bash

|

||||

# Exécuter l'inférence avec un modèle SAM

|

||||

yolo predict model=sam_b.pt source=path/to/image.jpg

|

||||

```

|

||||

|

||||

- La logique ici est de segmenter toute l'image si vous ne passez aucun prompt (bboxes/points/masks).

|

||||

|

||||

!!! Example "Exemple SAMPredictor"

|

||||

|

||||

De cette manière, vous pouvez définir l'image une fois et exécuter l'inférence des prompts plusieurs fois sans exécuter l'encodeur d'image plusieurs fois.

|

||||

|

||||

=== "Inférence avec des prompts"

|

||||

|

||||

```python

|

||||

from ultralytics.models.sam import Predictor as SAMPredictor

|

||||

|

||||

# Créer un SAMPredictor

|

||||

overrides = dict(conf=0.25, task='segment', mode='predict', imgsz=1024, model="mobile_sam.pt")

|

||||

predictor = SAMPredictor(overrides=overrides)

|

||||

|

||||

# Définir l'image

|

||||

predictor.set_image("ultralytics/assets/zidane.jpg") # définir avec un fichier image

|

||||

predictor.set_image(cv2.imread("ultralytics/assets/zidane.jpg")) # définir avec np.ndarray

|

||||

results = predictor(bboxes=[439, 437, 524, 709])

|

||||

results = predictor(points=[900, 370], labels=[1])

|

||||

|

||||

# Réinitialiser l'image

|

||||

predictor.reset_image()

|

||||

```

|

||||

|

||||

Segmenter toute l'image avec des arguments supplémentaires.

|

||||

|

||||

=== "Segmenter tout"

|

||||

|

||||

```python

|

||||

from ultralytics.models.sam import Predictor as SAMPredictor

|

||||

|

||||

# Créer un SAMPredictor

|

||||

overrides = dict(conf=0.25, task='segment', mode='predict', imgsz=1024, model="mobile_sam.pt")

|

||||

predictor = SAMPredictor(overrides=overrides)

|

||||

|

||||

# Segmenter avec des arguments supplémentaires

|

||||

results = predictor(source="ultralytics/assets/zidane.jpg", crop_n_layers=1, points_stride=64)

|

||||

```

|

||||

|

||||

- Plus d'arguments supplémentaires pour `Segmenter tout` voir la référence [`Predictor/generate`](../../reference/models/sam/predict.md).

|

||||

|

||||

## Comparaison de SAM avec YOLOv8

|

||||

|

||||

Nous comparons ici le plus petit modèle SAM de Meta, SAM-b, avec le plus petit modèle de segmentation d'Ultralytics, [YOLOv8n-seg](../tasks/segment.md) :

|

||||

|

||||

| Modèle | Taille | Paramètres | Vitesse (CPU) |

|

||||

|--------------------------------------------------------------|-----------------------------------|-----------------------------|-------------------------------------|

|

||||

| SAM-b - Meta's SAM-b | 358 Mo | 94,7 M | 51096 ms/im |

|

||||

| [MobileSAM](mobile-sam.md) | 40,7 Mo | 10,1 M | 46122 ms/im |

|

||||

| [FastSAM-s](fast-sam.md) with YOLOv8 backbone | 23,7 Mo | 11,8 M | 115 ms/im |

|

||||

| YOLOv8n-seg - Ultralytics [YOLOv8n-seg](../tasks/segment.md) | **6,7 Mo** (53,4 fois plus petit) | **3,4 M** (27,9 fois moins) | **59 ms/im** (866 fois plus rapide) |

|

||||

|

||||

Cette comparaison montre les différences d'ordre de grandeur dans les tailles et les vitesses des modèles. Alors que SAM présente des fonctionnalités uniques pour la segmentation automatique, il ne rivalise pas directement avec les modèles de segmentation YOLOv8, qui sont plus petits, plus rapides et plus efficaces.

|

||||

|

||||

Tests effectués sur un MacBook Apple M2 de 2023 avec 16 Go de RAM. Pour reproduire ce test :

|

||||

|

||||

!!! Example "Exemple"

|

||||

|

||||

=== "Python"

|

||||

```python

|

||||

from ultralytics import FastSAM, SAM, YOLO

|

||||

|

||||

# Profiler SAM-b

|

||||

modèle = SAM('sam_b.pt')

|

||||

modèle.info()

|

||||

modèle('ultralytics/assets')

|

||||

|

||||

# Profiler MobileSAM

|

||||

modèle = SAM('mobile_sam.pt')

|

||||

modèle.info()

|

||||

modèle('ultralytics/assets')

|

||||

|

||||

# Profiler FastSAM-s

|

||||

modèle = FastSAM('FastSAM-s.pt')

|

||||

modèle.info()

|

||||

modèle('ultralytics/assets')

|

||||

|

||||

# Profiler YOLOv8n-seg

|

||||

modèle = YOLO('yolov8n-seg.pt')

|

||||

modèle.info()

|

||||

modèle('ultralytics/assets')

|

||||

```

|

||||

|

||||

## Annotation automatique : Un moyen rapide d'obtenir des jeux de données de segmentation

|

||||

|

||||

L'annotation automatique est une fonctionnalité clé de SAM, permettant aux utilisateurs de générer un [jeu de données de segmentation](https://docs.ultralytics.com/datasets/segment) à l'aide d'un modèle de détection pré-entraîné. Cette fonctionnalité permet une annotation rapide et précise d'un grand nombre d'images, en contournant la nécessité d'une annotation manuelle chronophage.

|

||||

|

||||

### Générez votre jeu de données de segmentation à l'aide d'un modèle de détection

|

||||

|

||||

Pour annoter automatiquement votre jeu de données avec le framework Ultralytics, utilisez la fonction `auto_annotate` comme indiqué ci-dessous :

|

||||

|

||||

!!! Example "Exemple"

|

||||

|

||||

=== "Python"

|

||||

```python

|

||||

from ultralytics.data.annotator import auto_annotate

|

||||

|

||||

auto_annotate(data="path/to/images", det_model="yolov8x.pt", sam_model='sam_b.pt')

|

||||

```

|

||||

|

||||

| Argument | Type | Description | Default |

|

||||

|------------|----------------------|------------------------------------------------------------------------------------------------------------------------|--------------|

|

||||

| data | str | Chemin d'accès à un dossier contenant les images à annoter. | |

|

||||

| det_model | str, optionnel | Modèle de détection pré-entraîné YOLO. Par défaut, 'yolov8x.pt'. | 'yolov8x.pt' |

|

||||

| sam_model | str, optionnel | Modèle de segmentation pré-entraîné SAM. Par défaut, 'sam_b.pt'. | 'sam_b.pt' |

|

||||

| device | str, optionnel | Appareil sur lequel exécuter les modèles. Par défaut, une chaîne vide (CPU ou GPU, si disponible). | |

|

||||

| output_dir | str, None, optionnel | Répertoire pour enregistrer les résultats annotés. Par défaut, un dossier 'labels' dans le même répertoire que 'data'. | None |

|

||||

|

||||

La fonction `auto_annotate` prend en compte le chemin de vos images, avec des arguments optionnels pour spécifier les modèles de détection et de segmentation SAM pré-entraînés, l'appareil sur lequel exécuter les modèles et le répertoire de sortie pour enregistrer les résultats annotés.

|

||||

|

||||

L'annotation automatique avec des modèles pré-entraînés peut réduire considérablement le temps et les efforts nécessaires pour créer des jeux de données de segmentation de haute qualité. Cette fonctionnalité est particulièrement bénéfique pour les chercheurs et les développeurs travaillant avec de grandes collections d'images, car elle leur permet de se concentrer sur le développement et l'évaluation des modèles plutôt que sur l'annotation manuelle.

|

||||

|

||||

## Citations et remerciements

|

||||

|

||||

Si vous trouvez SAM utile dans vos travaux de recherche ou de développement, veuillez envisager de citer notre article :

|

||||

|

||||

!!! Quote ""

|

||||

|

||||

=== "BibTeX"

|

||||

|

||||

```bibtex

|

||||

@misc{kirillov2023segment,

|

||||

title={Segment Anything},

|

||||

author={Alexander Kirillov and Eric Mintun and Nikhila Ravi and Hanzi Mao and Chloe Rolland and Laura Gustafson and Tete Xiao and Spencer Whitehead and Alexander C. Berg and Wan-Yen Lo and Piotr Dollár and Ross Girshick},

|

||||

year={2023},

|

||||

eprint={2304.02643},

|

||||

archivePrefix={arXiv},

|

||||

primaryClass={cs.CV}

|

||||

}

|

||||

```

|

||||

|

||||

Nous tenons à exprimer notre gratitude à Meta AI pour la création et la maintenance de cette ressource précieuse pour la communauté de la vision par ordinateur.

|

||||

|

||||

*keywords: Segment Anything, Segment Anything Model, SAM, Meta SAM, segmentation d'image, segmentation promptable, performances hors échantillon, jeu de données SA-1B, architecture avancée, annotation automatique, Ultralytics, modèles pré-entraînés, SAM de base, SAM large, segmentation d'instance, vision par ordinateur, IA, intelligence artificielle, apprentissage automatique, annotation de données, masques de segmentation, modèle de détection, modèle de détection YOLO, bibtex, Meta AI.*

|

||||

121

docs/fr/models/yolo-nas.md

Normal file

121

docs/fr/models/yolo-nas.md

Normal file

|

|

@ -0,0 +1,121 @@

|

|||

---

|

||||

comments: true

|

||||

description: Découvrez une documentation détaillée sur YOLO-NAS, un modèle de détection d'objets supérieur. Apprenez-en davantage sur ses fonctionnalités, les modèles pré-entraînés, son utilisation avec l'API Python d'Ultralytics, et bien plus encore.

|

||||

keywords: YOLO-NAS, Deci AI, détection d'objets, apprentissage profond, recherche architecturale neuronale, API Python d'Ultralytics, modèle YOLO, modèles pré-entraînés, quantification, optimisation, COCO, Objects365, Roboflow 100

|

||||

---

|

||||

|

||||

# YOLO-NAS

|

||||

|

||||

## Aperçu

|

||||

|

||||

Développé par Deci AI, YOLO-NAS est un modèle de détection d'objets révolutionnaire. Il est le fruit d'une technologie avancée de recherche architecturale neuronale, minutieusement conçu pour pallier les limitations des précédents modèles YOLO. Avec des améliorations significatives en matière de prise en charge de la quantification et de compromis entre précision et latence, YOLO-NAS représente une avancée majeure en matière de détection d'objets.

|

||||

|

||||

|

||||

**Aperçu de YOLO-NAS**. YOLO-NAS utilise des blocs adaptés à la quantification et une quantification sélective pour des performances optimales. Le modèle, une fois converti en version quantifiée INT8, présente une baisse de précision minimale, ce qui constitue une amélioration significative par rapport aux autres modèles. Ces avancées aboutissent à une architecture supérieure offrant des capacités de détection d'objets inégalées et des performances exceptionnelles.

|

||||

|

||||

### Fonctionnalités clés

|

||||

|

||||

- **Bloc de base compatible avec la quantification:** YOLO-NAS introduit un nouveau bloc de base adapté à la quantification, ce qui permet de pallier l'une des principales limitations des précédents modèles YOLO.

|

||||

- **Entraînement sophistiqué et quantification:** YOLO-NAS utilise des schémas d'entraînement avancés et une quantification après l'entraînement pour améliorer les performances.

|

||||

- **Optimisation AutoNAC et pré-entraînement:** YOLO-NAS utilise l'optimisation AutoNAC et est pré-entraîné sur des ensembles de données renommés tels que COCO, Objects365 et Roboflow 100. Ce pré-entraînement le rend extrêmement adapté aux tâches de détection d'objets ultérieures dans des environnements de production.

|

||||

|

||||

## Modèles pré-entraînés

|

||||

|

||||

Découvrez la puissance de la détection d'objets de nouvelle génération avec les modèles YOLO-NAS pré-entraînés fournis par Ultralytics. Ces modèles sont conçus pour offrir des performances exceptionnelles en termes de vitesse et de précision. Choisissez parmi une variété d'options adaptées à vos besoins spécifiques :

|

||||

|

||||

| Modèle | mAP | Latence (ms) |

|

||||

|------------------|-------|--------------|

|

||||

| YOLO-NAS S | 47.5 | 3.21 |

|

||||

| YOLO-NAS M | 51.55 | 5.85 |

|

||||

| YOLO-NAS L | 52.22 | 7.87 |

|

||||

| YOLO-NAS S INT-8 | 47.03 | 2.36 |

|

||||

| YOLO-NAS M INT-8 | 51.0 | 3.78 |

|

||||

| YOLO-NAS L INT-8 | 52.1 | 4.78 |

|

||||

|

||||

Chaque variante de modèle est conçue pour offrir un équilibre entre la précision moyenne (mAP) et la latence, vous permettant ainsi d'optimiser vos tâches de détection d'objets en termes de performance et de vitesse.

|

||||

|

||||

## Exemples d'utilisation

|

||||

|

||||

Ultralytics a rendu les modèles YOLO-NAS faciles à intégrer dans vos applications Python grâce à notre package Python `ultralytics`. Le package fournit une interface conviviale pour simplifier le processus.

|

||||

|

||||

Les exemples suivants montrent comment utiliser les modèles YOLO-NAS avec le package `ultralytics` pour l'inférence et la validation :

|

||||

|

||||

### Exemples d'inférence et de validation

|

||||

|

||||

Dans cet exemple, nous validons YOLO-NAS-s sur l'ensemble de données COCO8.

|

||||

|

||||

!!! Example "Exemple"

|

||||

|

||||

Cet exemple fournit un code simple pour l'inférence et la validation de YOLO-NAS. Pour gérer les résultats de l'inférence, consultez le mode [Predict](../modes/predict.md). Pour utiliser YOLO-NAS avec des modes supplémentaires, consultez [Val](../modes/val.md) et [Export](../modes/export.md). L'entraînement n'est pas pris en charge pour YOLO-NAS avec le package `ultralytics`.

|

||||

|

||||

=== "Python"

|

||||

|

||||

Il est possible de passer des modèles pré-entraînés `*.pt` de PyTorch à la classe `NAS()` pour créer une instance de modèle en Python :

|

||||

|

||||

```python

|

||||

from ultralytics import NAS

|

||||

|

||||

# Charger un modèle YOLO-NAS-s pré-entraîné sur COCO

|

||||

model = NAS('yolo_nas_s.pt')

|

||||

|

||||

# Afficher les informations sur le modèle (facultatif)

|

||||

model.info()

|

||||

|

||||

# Valider le modèle sur l'ensemble de données COCO8

|

||||

results = model.val(data='coco8.yaml')

|

||||

|

||||

# Effectuer une inférence avec le modèle YOLO-NAS-s sur l'image 'bus.jpg'

|

||||

results = model('path/to/bus.jpg')

|

||||

```

|

||||

|

||||

=== "CLI"

|

||||

|

||||

Des commandes CLI sont disponibles pour exécuter directement les modèles :

|

||||

|

||||

```bash

|

||||

# Charger un modèle YOLO-NAS-s pré-entraîné sur COCO et valider ses performances sur l'ensemble de données COCO8

|

||||

yolo val model=yolo_nas_s.pt data=coco8.yaml

|

||||

|

||||

# Charger un modèle YOLO-NAS-s pré-entraîné sur COCO et effectuer une inférence sur l'image 'bus.jpg'

|

||||

yolo predict model=yolo_nas_s.pt source=path/to/bus.jpg

|

||||

```

|

||||

|

||||

## Tâches et modes pris en charge

|

||||

|

||||

Nous proposons trois variantes des modèles YOLO-NAS : Small (s), Medium (m) et Large (l). Chaque variante est conçue pour répondre à des besoins computationnels et de performances différents :

|

||||

|

||||

- **YOLO-NAS-s** : Optimisé pour les environnements où les ressources computationnelles sont limitées mais l'efficacité est primordiale.

|

||||

- **YOLO-NAS-m** : Offre une approche équilibrée, adaptée à la détection d'objets polyvalente avec une précision accrue.

|

||||

- **YOLO-NAS-l** : Adapté aux scénarios nécessitant la plus haute précision, où les ressources computationnelles sont moins contraignantes.

|

||||

|

||||

Voici un aperçu détaillé de chaque modèle, comprenant des liens vers leurs poids pré-entraînés, les tâches qu'ils prennent en charge et leur compatibilité avec différents modes opérationnels.

|

||||

|

||||

| Type de modèle | Poids pré-entraînés | Tâches prises en charge | Inférence | Validation | Entraînement | Export |

|

||||

|----------------|-----------------------------------------------------------------------------------------------|------------------------------------------|-----------|------------|--------------|--------|

|

||||

| YOLO-NAS-s | [yolo_nas_s.pt](https://github.com/ultralytics/assets/releases/download/v0.0.0/yolo_nas_s.pt) | [Détection d'objets](../tasks/detect.md) | ✅ | ✅ | ❌ | ✅ |

|

||||

| YOLO-NAS-m | [yolo_nas_m.pt](https://github.com/ultralytics/assets/releases/download/v0.0.0/yolo_nas_m.pt) | [Détection d'objets](../tasks/detect.md) | ✅ | ✅ | ❌ | ✅ |

|

||||

| YOLO-NAS-l | [yolo_nas_l.pt](https://github.com/ultralytics/assets/releases/download/v0.0.0/yolo_nas_l.pt) | [Détection d'objets](../tasks/detect.md) | ✅ | ✅ | ❌ | ✅ |

|

||||

|

||||

## Citations et remerciements

|

||||

|

||||

Si vous utilisez YOLO-NAS dans vos travaux de recherche ou de développement, veuillez citer SuperGradients :

|

||||

|

||||

!!! Quote ""

|

||||

|

||||

=== "BibTeX"

|

||||

|

||||

```bibtex

|

||||

@misc{supergradients,

|

||||

doi = {10.5281/ZENODO.7789328},

|

||||

url = {https://zenodo.org/record/7789328},

|

||||

author = {Aharon, Shay and {Louis-Dupont} and {Ofri Masad} and Yurkova, Kate and {Lotem Fridman} and {Lkdci} and Khvedchenya, Eugene and Rubin, Ran and Bagrov, Natan and Tymchenko, Borys and Keren, Tomer and Zhilko, Alexander and {Eran-Deci}},

|

||||

title = {Super-Gradients},

|

||||

publisher = {GitHub},

|

||||

journal = {GitHub repository},

|

||||

year = {2021},

|

||||

}

|

||||

```

|

||||

|

||||

Nous exprimons notre gratitude à l'équipe [Super-Gradients](https://github.com/Deci-AI/super-gradients/) de Deci AI pour ses efforts dans la création et la maintenance de cette précieuse ressource pour la communauté de la vision par ordinateur. Nous sommes convaincus que YOLO-NAS, avec son architecture innovante et ses capacités de détection d'objets supérieures, deviendra un outil essentiel pour les développeurs et les chercheurs.

|

||||

|

||||

*keywords: YOLO-NAS, Deci AI, détection d'objets, apprentissage profond, recherche architecturale neuronale, API Python d'Ultralytics, modèle YOLO, SuperGradients, modèles pré-entraînés, bloc de base compatible avec la quantification, schémas d'entraînement avancés, quantification après l'entraînement, optimisation AutoNAC, COCO, Objects365, Roboflow 100*

|

||||

98

docs/fr/models/yolov3.md

Normal file

98

docs/fr/models/yolov3.md

Normal file

|

|

@ -0,0 +1,98 @@

|

|||

---

|

||||

comments: true

|

||||

description: Obtenez un aperçu des modèles YOLOv3, YOLOv3-Ultralytics et YOLOv3u. Apprenez-en davantage sur leurs fonctionnalités clés, leur utilisation et les tâches prises en charge pour la détection d'objets.

|

||||

keywords: YOLOv3, YOLOv3-Ultralytics, YOLOv3u, Détection d'objets, Inférence, Entraînement, Ultralytics

|

||||

---

|

||||

|

||||

# YOLOv3, YOLOv3-Ultralytics et YOLOv3u

|

||||

|

||||

## Aperçu

|

||||

|

||||

Ce document présente un aperçu de trois modèles de détection d'objets étroitement liés, à savoir [YOLOv3](https://pjreddie.com/darknet/yolo/), [YOLOv3-Ultralytics](https://github.com/ultralytics/yolov3) et [YOLOv3u](https://github.com/ultralytics/ultralytics).

|

||||

|

||||

1. **YOLOv3**: Il s'agit de la troisième version de l'algorithme de détection d'objets You Only Look Once (YOLO). Initiée par Joseph Redmon, YOLOv3 a amélioré ses prédécesseurs en introduisant des fonctionnalités telles que des prédictions à plusieurs échelles et trois tailles différentes de noyaux de détection.

|

||||

|

||||

2. **YOLOv3-Ultralytics**: Il s'agit de l'implémentation par Ultralytics du modèle YOLOv3. Il reproduit l'architecture d'origine de YOLOv3 et offre des fonctionnalités supplémentaires, telles que la prise en charge de plusieurs modèles pré-entraînés et des options de personnalisation plus faciles.

|

||||

|

||||

3. **YOLOv3u**: Il s'agit d'une version mise à jour de YOLOv3-Ultralytics qui intègre la nouvelle tête de détection sans ancrage et sans objectivité utilisée dans les modèles YOLOv8. YOLOv3u conserve la même architecture de base et de cou de YOLOv3, mais avec la nouvelle tête de détection de YOLOv8.

|

||||

|

||||

|

||||

|

||||

## Caractéristiques clés

|

||||

|

||||

- **YOLOv3**: A introduit l'utilisation de trois échelles différentes pour la détection, en tirant parti de trois tailles différentes de noyaux de détection : 13x13, 26x26 et 52x52. Cela a considérablement amélioré la précision de la détection pour les objets de différentes tailles. De plus, YOLOv3 a ajouté des fonctionnalités telles que des prédictions multi-étiquettes pour chaque boîte englobante et un meilleur réseau d'extraction de caractéristiques.

|

||||

|

||||

- **YOLOv3-Ultralytics**: L'implémentation d'Ultralytics de YOLOv3 offre les mêmes performances que le modèle d'origine, mais propose également un support supplémentaire pour plus de modèles pré-entraînés, des méthodes d'entraînement supplémentaires et des options de personnalisation plus faciles. Cela le rend plus polyvalent et convivial pour les applications pratiques.

|

||||

|

||||

- **YOLOv3u**: Ce modèle mis à jour intègre la nouvelle tête de détection sans ancrage et sans objectivité de YOLOv8. En éliminant le besoin de boîtes d'ancrage prédéfinies et de scores d'objectivité, cette conception de tête de détection peut améliorer la capacité du modèle à détecter des objets de différentes tailles et formes. Cela rend YOLOv3u plus robuste et précis pour les tâches de détection d'objets.

|

||||

|

||||

## Tâches et modes pris en charge

|

||||

|

||||